В библиотеке Pandas есть несколько функций для решения этой проблемы, и value_counts — одна из них. Она возвращает объект, содержащий уникальные значения из dataframe Pandas в отсортированном порядке. Однако многие забывают об этой возможности и используют параметры по умолчанию. В этом материале посмотрим, как получить максимум пользы от value_counts, изменив параметры по умолчанию.

Что такое функция value_counts()?

Функция value_counts() используется для получения Series, содержащего уникальные значения. Она вернет результат, отсортированный в порядке убывания, так что первый элемент в коллекции будет самым встречаемым. NA-значения не включены в результат.

Синтаксисdf['your_column'].value_counts() — вернет количество уникальных совпадений в определенной колонке.

Важно заметить, что value_counts работает только с series, но не dataframe. Поэтому нужно указать одни квадратные скобки df['your_column'], а не пару df[['your_column']].

Параметры:

normalize(bool, по умолчанию False) — еслиTrue, то возвращаемый объект будет содержать значения относительно частоты встречаемых значений.sort(bool, по умолчанию True) — сортировка по частоте.ascending(bool, по умолчанию False) — сортировка по возрастанию.bins(int) — вместе подсчета значений группирует их по отрезкам, но это работает только с числовыми данными.- dropna (bool, по умолчанию True) — не включать количество NaN.

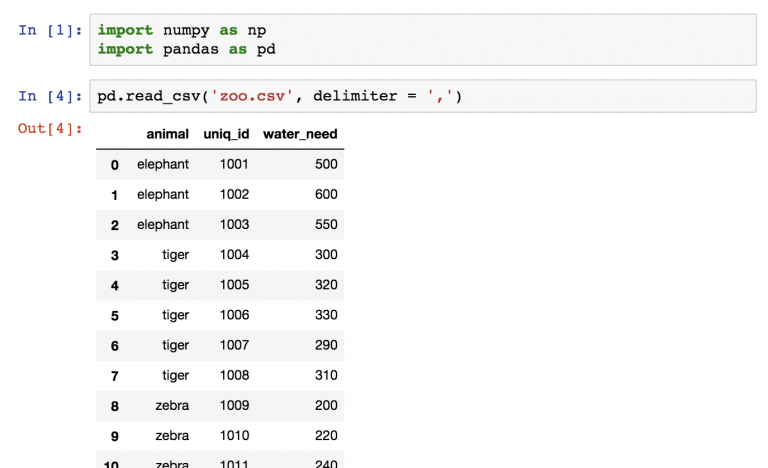

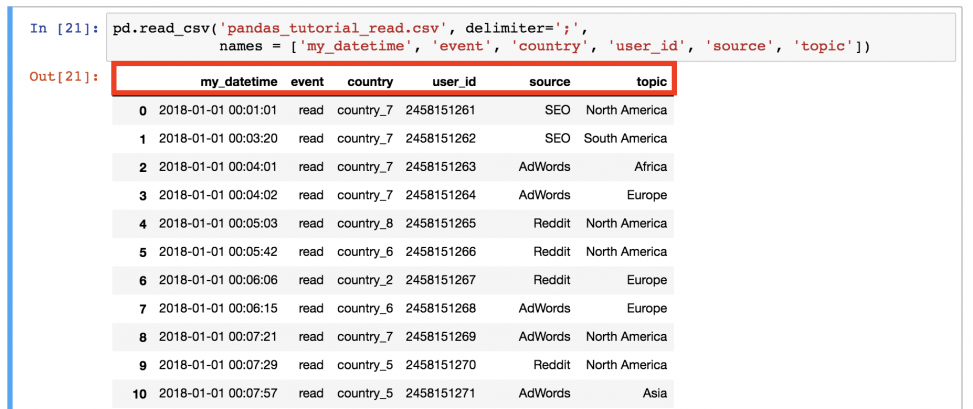

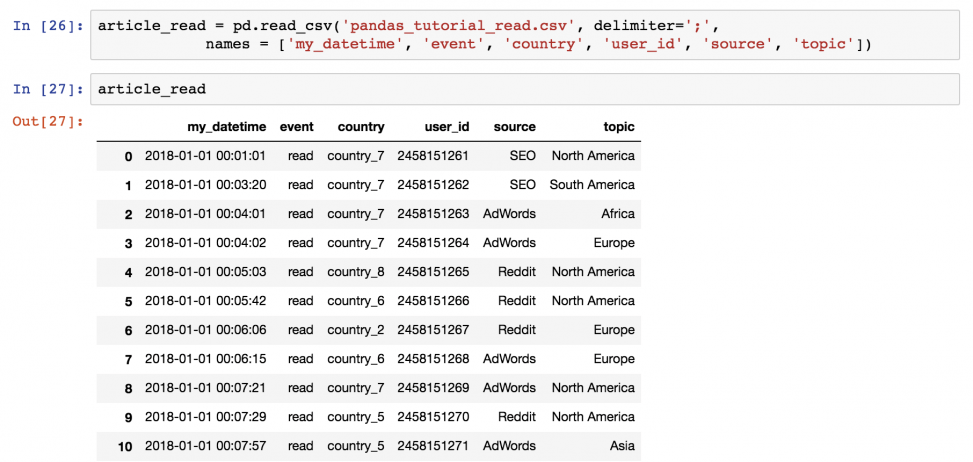

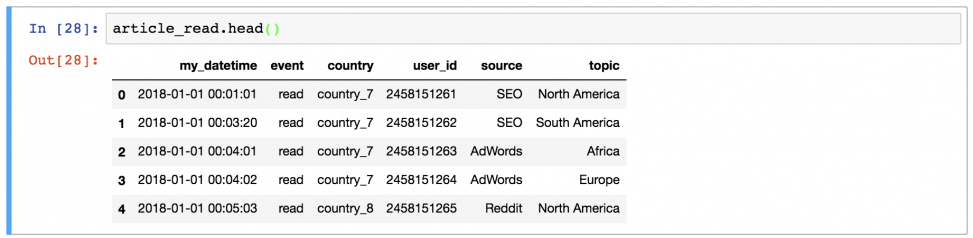

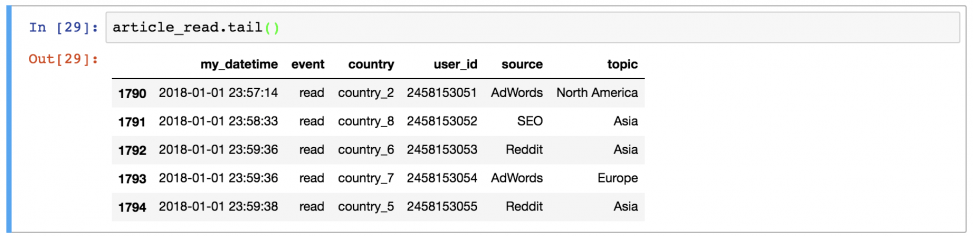

Загрузка данных для демонстрации

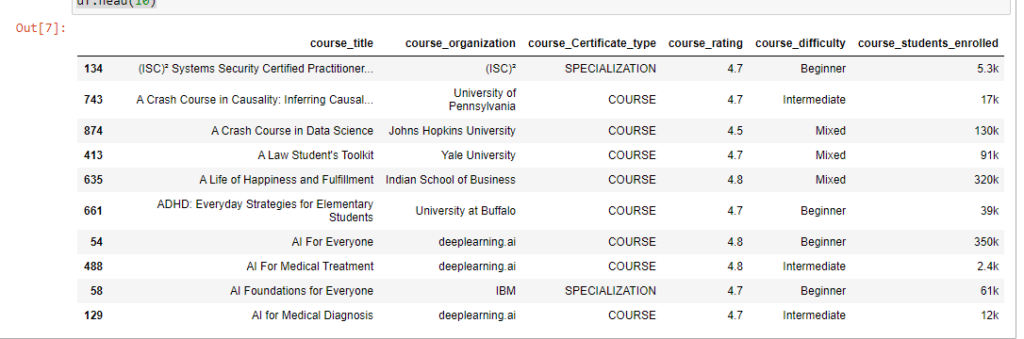

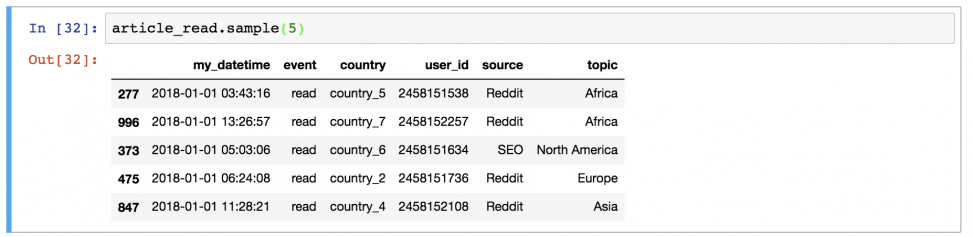

Рассмотрим, как использовать этот метод на реальных данных. Возьмем в качестве примера датасет из курса Coursera на Kaggle.

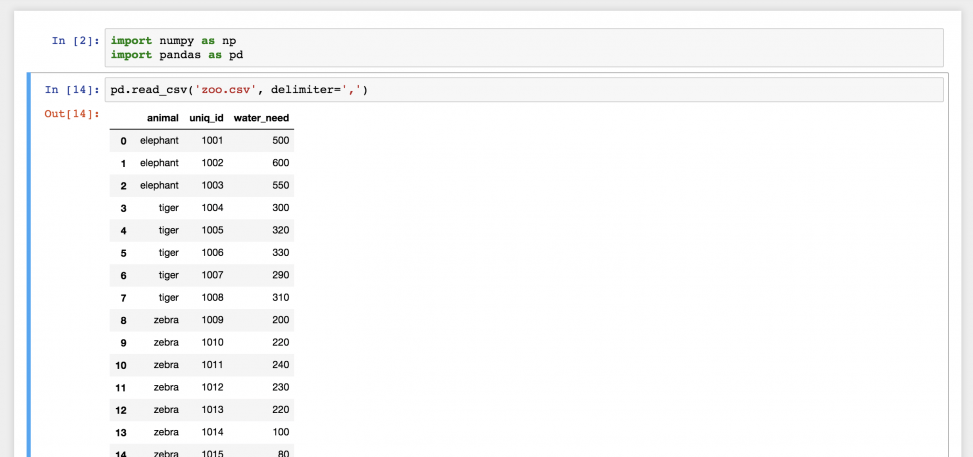

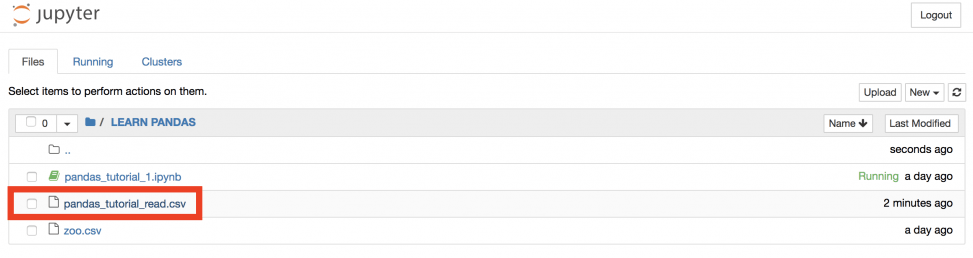

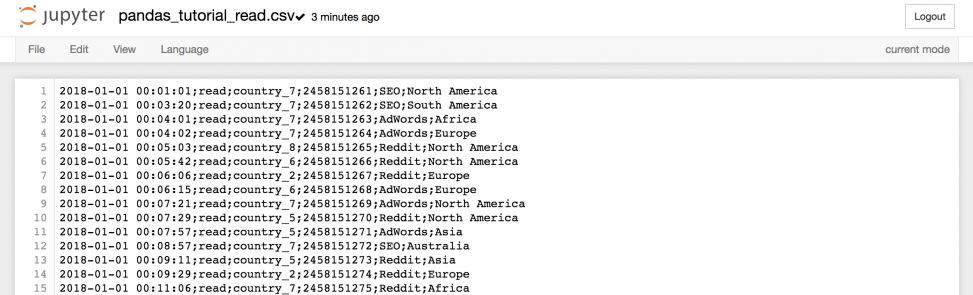

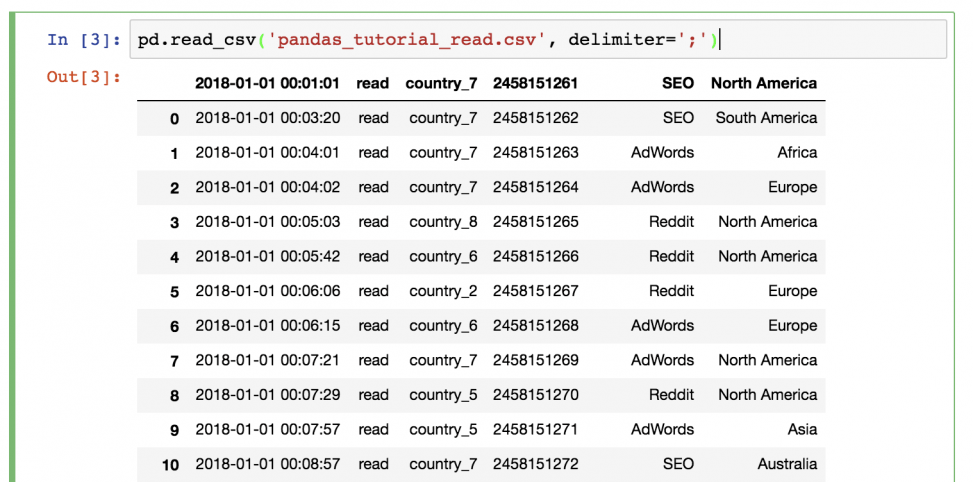

Для начала импортируем нужные библиотеки и сами данные. Это нужно в любом проекте. После этого проанализируем данные в notebook Jupyter.

# импорт библиотеки

import pandas as pd

# Загрузка данных

df = pd.read_csv('Downloads/coursea_data.csv', index_col=0)

# проверка данных из csv

df.head(10)

Проверьте, сколько записей в датасете и есть ли у нас пропуски.

df.info()

Результат показывает, что в наборе 981 запись, и нет ни одного NA.

<class 'pandas.core.frame.DataFrame'>

Int64Index: 891 entries, 134 to 163

Data columns (total 6 columns):

# Column Non-Null Count Dtype

--- ------ -------------- -----

0 course_title 891 non-null object

1 course_organization 891 non-null object

2 course_Certificate_type 891 non-null object

3 course_rating 891 non-null float64

4 course_difficulty 891 non-null object

5 course_students_enrolled 891 non-null object

dtypes: float64(1), object(5)

memory usage: 48.7+ KB1. value_counts с параметрами по умолчанию

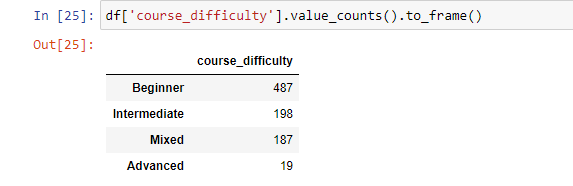

Теперь можно начинать использовать функцию value_counts. Начнем с базового применения функции.

Синтаксис: df['your_column'].value_counts().

Получим количество каждого значения для колонки «course_difficulty».

Функция value_counts вернет количество совпадений всех уникальных значений по заданному индексу без пропусков. Это позволит увидеть, что больше всего курсов с уровнем сложности «Начинающий», после этого идут «Средний» и «Смешанный». А «Сложный» на последнем месте.

df['course_difficulty'].value_counts()

---------------------------------------------------

Beginner 487

Intermediate 198

Mixed 187

Advanced 19

Name: course_difficulty, dtype: int64Теперь время поработать с параметрами.

2. Сортировка по возрастанию

По умолчанию value_counts() возвращает данные по убыванию. Изменит поведение можно, задав значение True для параметра ascending.

Синтаксис: df['your_column'].value_counts(ascending=True).

df['course_difficulty'].value_counts(ascending=True)

---------------------------------------------------

Advanced 19

Mixed 187

Intermediate 198

Beginner 487

Name: course_difficulty, dtype: int643. Сортировка в алфавитном порядке

В определенных случаях может существовать необходимость отсортировать записи в алфавитном порядке. Это делается с помощью добавления sort_index(ascending=True) после value_counts().

По умолчанию функция сортирует «course_difficulty» по количеству совпадений, а с sort_index сортирует по индексу (имени колонки, для которой и используется функция):

df['course_difficulty'].value_counts().sort_index(ascending=True)

---------------------------------------------------

Advanced 19

Beginner 487

Intermediate 198

Mixed 187

Name: course_difficulty, dtype: int64Если же требуется отобразить value_counts() в обратном алфавитном порядке, то нужно изменить направление сортировки: .sort_index(ascending=False).

4. Сортировка по значению, а затем по алфавиту

Для этого примера используем другой датасет.

df_fruit = pd.DataFrame({

'fruit':

['хурма']*5 + ['яблоки']*5 + ['бананы']*3 +

['персики']*3 + ['морковь']*3 + ['абрикосы'] + ['манго']*2

})

Так, нужно получить вывод, отсортированный в первую очередь по количеству совпадений значений, а потом уже и по алфавиту. Это можно сделать, объединив value_counts() c sort_index(ascending=False) и sort_values(ascending=False).

df_fruit['fruit'].value_counts()\

.sort_index(ascending=False)\

.sort_values(ascending=False)

-------------------------------------------------

хурма 5

яблоки 5

бананы 3

морковь 3

персики 3

манго 2

абрикосы 1

Name: fruit, dtype: int645. Относительная частота уникальных значений

Иногда нужно получить относительные значения, а не просто количество. С параметром normalize=True объект вернет относительную частоту уникальных значений. По умолчанию значение этого параметра равно False.

Синтаксис: df['your_column'].value_counts(normalize=True).

df['course_difficulty'].value_counts(normalize=True)

-------------------------------------------------

Beginner 0.546577

Intermediate 0.222222

Mixed 0.209877

Advanced 0.021324

Name: course_difficulty, dtype: float646. value_counts() для разбивки данных на дискретные интервалы

Еще один трюк, который часто игнорируют. value_counts() можно использовать для разбивки данных на дискретные интервалы с помощью параметра bin. Это работает только с числовыми данными. Принцип напоминает pd.cut. Посмотрим как это работает на примере колонки «course_rating». Сгруппируем значения колонки на 4 группы.

Синтаксис: df['your_column'].value_counts(bin=количество групп).

df['course_rating'].value_counts(bins=4)

-------------------------------------------------

(4.575, 5.0] 745

(4.15, 4.575] 139

(3.725, 4.15] 5

(3.297, 3.725] 2

Name: course_rating, dtype: int64Бинниг позволяет легко получить инсайты. Так, можно увидеть, что большая часть людей оценивает курс на 4.5. И лишь несколько курсов имеют оценку ниже 4.15.

7. value_counts() с пропусками

По умолчанию количество значений NaN не включается в результат. Но это поведение можно изменить, задав значение False для параметра dropna. Поскольку в наборе данных нет нулевых значений, в этом примере это ни на что не повлияет. Но сам параметр следует запомнить.

Синтаксис: df['your_column'].value_counts(dropna=False).

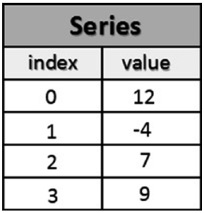

8. value_counts() как dataframe

Как уже было отмечено, value_counts() возвращает Series, а не Dataframe. Если же нужно получить результаты в последнем виде, то для этого можно использовать функцию .to_frame() после .value_counts().

Синтаксис: df['your_column'].value_counts().to_frame().

Это будет выглядеть следующим образом:

Если нужно задать имя для колонки или переименовать существующую, то эту конвертацию можно реализовать другим путем.

value_counts = df['course_difficulty'].value_counts()

# преобразование в df и присвоение новых имен колонкам

df_value_counts = pd.DataFrame(value_counts)

df_value_counts = df_value_counts.reset_index()

df_value_counts.columns = ['unique_values', 'counts for course_difficulty']

df_value_counts

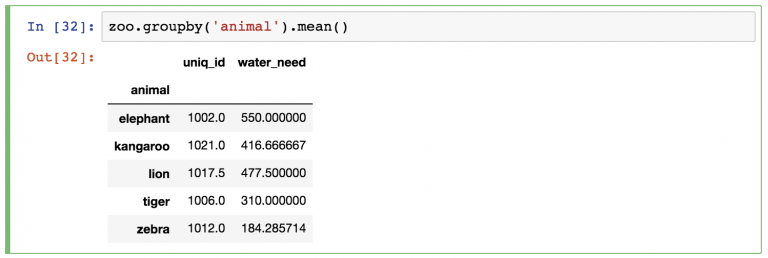

Groupby и value_counts

Groupby — очень популярный метод в Pandas. С его помощью можно сгруппировать результат по одной колонке и посчитать значения в другой.

Синтаксис: df.groupby('your_column_1')['your_column_2'].value_counts().

Так, с помощью groupby и value_counts можно посчитать количество типов сертификатов для каждого уровня сложности курсов.

df.groupby('course_difficulty')['course_Certificate_type'].value_counts()

-------------------------------------------------

course_difficulty course_Certificate_type

Advanced SPECIALIZATION 10

COURSE 9

Beginner COURSE 282

SPECIALIZATION 196

PROFESSIONAL CERTIFICATE 9

Intermediate COURSE 104

SPECIALIZATION 91

PROFESSIONAL CERTIFICATE 3

Mixed COURSE 187

Name: course_Certificate_type, dtype: int64Это мульти-индекс, позволяющий иметь несколько уровней индексов в dataframe. В этом случае сложность курса соответствует нулевому уровню индекса, а тип сертификата — первому.

Фильтрация значений по минимум и максимум

Работая с набором данных, может потребоваться вернуть количество ограниченных вхождений с помощью value_counts().

Синтаксис: df['your_column'].value_counts().loc[lambda x : x > 1].

Этот код отфильтрует все значения уникальных данных и покажет только те, где значение больше единицы.

Для примера ограничим рейтинг курса значением 4.

df.groupby('course_difficulty')['coudf['course_rating']\

.value_counts().loc[lambda x: x > 4]

-------------------------------------------------

4.8 256

4.7 251

4.6 168

4.5 80

4.9 68

4.4 34

4.3 15

4.2 10

Name: course_rating, dtype: int64value_counts() — удобный инструмент, позволяющий делать удобный анализ в одну строку.

Тест на знание функции value_counts

Помимо чтения и записи рассмотрим, как записывать несколько DataFrame в Excel-файл, как считывать определенные строки и колонки из таблицы и как задавать имена для одной или нескольких таблиц в файле.

Установка Pandas

Для начала Pandas нужно установить. Проще всего это сделать с помощью pip.

Если у вас Windows, Linux или macOS:

pip install pandas # или pip3В процессе можно столкнуться с ошибками ModuleNotFoundError или ImportError при попытке запустить этот код. Например:

ModuleNotFoundError: No module named 'openpyxl'В таком случае нужно установить недостающие модули:

pip install openpyxl xlsxwriter xlrd # или pip3Запись в файл Excel с python

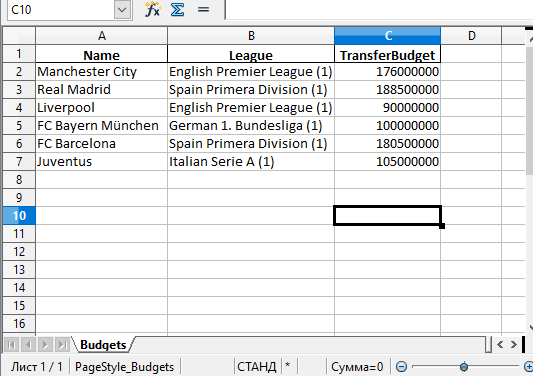

Будем хранить информацию, которую нужно записать в файл Excel, в DataFrame. А с помощью встроенной функции to_excel() ее можно будет записать в Excel.

Сначала импортируем модуль pandas. Потом используем словарь для заполнения DataFrame:

import pandas as pd

df = pd.DataFrame({'Name': ['Manchester City', 'Real Madrid', 'Liverpool',

'FC Bayern München', 'FC Barcelona', 'Juventus'],

'League': ['English Premier League (1)', 'Spain Primera Division (1)',

'English Premier League (1)', 'German 1. Bundesliga (1)',

'Spain Primera Division (1)', 'Italian Serie A (1)'],

'TransferBudget': [176000000, 188500000, 90000000,

100000000, 180500000, 105000000]})

Ключи в словаре — это названия колонок. А значения станут строками с информацией.

Теперь можно использовать функцию to_excel() для записи содержимого в файл. Единственный аргумент — это путь к файлу:

df.to_excel('./teams.xlsx')

А вот и созданный файл Excel:

Стоит обратить внимание на то, что в этом примере не использовались параметры. Таким образом название листа в файле останется по умолчанию — «Sheet1». В файле может быть и дополнительная колонка с числами. Эти числа представляют собой индексы, которые взяты напрямую из DataFrame.

Поменять название листа можно, добавив параметр sheet_name в вызов to_excel():

df.to_excel('./teams.xlsx', sheet_name='Budgets', index=False)

Также можно добавили параметр index со значением False, чтобы избавиться от колонки с индексами. Теперь файл Excel будет выглядеть следующим образом:

Запись нескольких DataFrame в файл Excel

Также есть возможность записать несколько DataFrame в файл Excel. Для этого можно указать отдельный лист для каждого объекта:

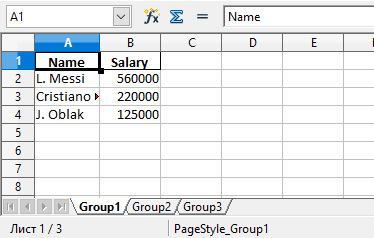

salaries1 = pd.DataFrame({'Name': ['L. Messi', 'Cristiano Ronaldo', 'J. Oblak'],

'Salary': [560000, 220000, 125000]})

salaries2 = pd.DataFrame({'Name': ['K. De Bruyne', 'Neymar Jr', 'R. Lewandowski'],

'Salary': [370000, 270000, 240000]})

salaries3 = pd.DataFrame({'Name': ['Alisson', 'M. ter Stegen', 'M. Salah'],

'Salary': [160000, 260000, 250000]})

salary_sheets = {'Group1': salaries1, 'Group2': salaries2, 'Group3': salaries3}

writer = pd.ExcelWriter('./salaries.xlsx', engine='xlsxwriter')

for sheet_name in salary_sheets.keys():

salary_sheets[sheet_name].to_excel(writer, sheet_name=sheet_name, index=False)

writer.save()

Здесь создаются 3 разных DataFrame с разными названиями, которые включают имена сотрудников, а также размер их зарплаты. Каждый объект заполняется соответствующим словарем.

Объединим все три в переменной salary_sheets, где каждый ключ будет названием листа, а значение — объектом DataFrame.

Дальше используем движок xlsxwriter для создания объекта writer. Он и передается функции to_excel().

Перед записью пройдемся по ключам salary_sheets и для каждого ключа запишем содержимое в лист с соответствующим именем. Вот сгенерированный файл:

Можно увидеть, что в этом файле Excel есть три листа: Group1, Group2 и Group3. Каждый из этих листов содержит имена сотрудников и их зарплаты в соответствии с данными в трех DataFrame из кода.

Параметр движка в функции to_excel() используется для определения модуля, который задействуется библиотекой Pandas для создания файла Excel. В этом случае использовался xslswriter, который нужен для работы с классом ExcelWriter. Разные движка можно определять в соответствии с их функциями.

В зависимости от установленных в системе модулей Python другими параметрами для движка могут быть openpyxl (для xlsx или xlsm) и xlwt (для xls). Подробности о модуле xlswriter можно найти в официальной документации.

Наконец, в коде была строка writer.save(), которая нужна для сохранения файла на диске.

Чтение файлов Excel с python

По аналогии с записью объектов DataFrame в файл Excel, эти файлы можно и читать, сохраняя данные в объект DataFrame. Для этого достаточно воспользоваться функцией read_excel():

top_players = pd.read_excel('./top_players.xlsx')

top_players.head()

Содержимое финального объекта можно посмотреть с помощью функции head().

Примечание:

Этот способ самый простой, но он и способен прочесть лишь содержимое первого листа.

Посмотрим на вывод функции head():

| Name | Age | Overall | Potential | Positions | Club | |

|---|---|---|---|---|---|---|

| 0 | L. Messi | 33 | 93 | 93 | RW,ST,CF | FC Barcelona |

| 1 | Cristiano Ronaldo | 35 | 92 | 92 | ST,LW | Juventus |

| 2 | J. Oblak | 27 | 91 | 93 | GK | Atlético Madrid |

| 3 | K. De Bruyne | 29 | 91 | 91 | CAM,CM | Manchester City |

| 4 | Neymar Jr | 28 | 91 | 91 | LW,CAM | Paris Saint-Germain |

Pandas присваивает метку строки или числовой индекс объекту DataFrame по умолчанию при использовании функции read_excel().

Это поведение можно переписать, передав одну из колонок из файла в качестве параметра index_col:

top_players = pd.read_excel('./top_players.xlsx', index_col='Name')

top_players.head()

Результат будет следующим:

| Name | Age | Overall | Potential | Positions | Club |

|---|---|---|---|---|---|

| L. Messi | 33 | 93 | 93 | RW,ST,CF | FC Barcelona |

| Cristiano Ronaldo | 35 | 92 | 92 | ST,LW | Juventus |

| J. Oblak | 27 | 91 | 93 | GK | Atlético Madrid |

| K. De Bruyne | 29 | 91 | 91 | CAM,CM | Manchester City |

| Neymar Jr | 28 | 91 | 91 | LW,CAM | Paris Saint-Germain |

В этом примере индекс по умолчанию был заменен на колонку «Name» из файла. Однако этот способ стоит использовать только при наличии колонки со значениями, которые могут стать заменой для индексов.

Чтение определенных колонок из файла Excel

Иногда удобно прочитать содержимое файла целиком, но бывают случаи, когда требуется получить доступ к определенному элементу. Например, нужно считать значение элемента и присвоить его полю объекта.

Это делается с помощью функции read_excel() и параметра usecols. Например, можно ограничить функцию, чтобы она читала только определенные колонки. Добавим параметр, чтобы он читал колонки, которые соответствуют значениям «Name», «Overall» и «Potential».

Для этого укажем числовой индекс каждой колонки:

cols = [0, 2, 3]

top_players = pd.read_excel('./top_players.xlsx', usecols=cols)

top_players.head()

Вот что выдаст этот код:

| Name | Overall | Potential | |

|---|---|---|---|

| 0 | L. Messi | 93 | 93 |

| 1 | Cristiano Ronaldo | 92 | 92 |

| 2 | J. Oblak | 91 | 93 |

| 3 | K. De Bruyne | 91 | 91 |

| 4 | Neymar Jr | 91 | 91 |

Таким образом возвращаются лишь колонки из списка cols.

В DataFrame много встроенных возможностей. Легко изменять, добавлять и агрегировать данные. Даже можно строить сводные таблицы. И все это сохраняется в Excel одной строкой кода.

Рекомендую изучить DataFrame в моих уроках по Pandas.

Выводы

В этом материале были рассмотрены функции read_excel() и to_excel() из библиотеки Pandas. С их помощью можно считывать данные из файлов Excel и выполнять запись в них. С помощью различных параметров есть возможность менять поведение функций, создавая нужные файлы, не просто копируя содержимое из объекта DataFrame.

Манипуляция строками

Python — это популярный язык, который благодаря своей простоте часто используется для обработки строк и текста. Большая часть операций может быть выполнена даже с помощью встроенных функций. А для более сложных используются регулярные выражения.

Встроенные методы для работы со строками

В большинстве случаев имеются сложные строки, которые желательно разделять на части и присваивать их правильным переменным. Функция split() позволяет разбить тексты на части, используя разделитель в качестве ориентира. Им может быть, например, запятая.

>>> text = '16 Bolton Avenue , Boston'

>>> text.split(',')

['16 Bolton Avenue ', 'Boston']

По первому элементу видно, что в конце у него остается пробел. Чтобы решить эту проблему, вместе со split() нужно также использовать функцию strip(), которая обрезает пустое пространство (включая символы новой строки)

>>> tokens = [s.strip() for s in text.split(',')]

>>> tokens

['16 Bolton Avenue', 'Boston']

Результат — массив строк. Если элементов не много, то можно выполнить присваивание вот так:

>>> address, city = [s.strip() for s in text.split(',')]

>>> address

'16 Bolton Avenue'

>>> city

'Boston'

Помимо разбития текста на части часто требуется сделать обратное — конкатенировать разные строки, получив в результате текст большого объема. Самый простой способ — использовать оператор +.

>>> address + ',' + city

'16 Bolton Avenue, Boston'

Но это сработает только в том случае, если строк не больше двух-трех. Если же их больше, то есть метод join(). Его нужно применять к желаемому разделителю, передав в качестве аргумента список строк.

>>> strings = ['A+','A','A-','B','BB','BBB','C+']

>>> ';'.join(strings)

'A+;A;A-;B;BB;BBB;C+'

Еще один тип операции, которую можно выполнять со строкой — поиск отдельных частей, подстрок. В Python для этого есть ключевое слово, используемое для обнаружения подстрок.

>>> 'Boston' in text

True

Но имеются и две функции, которые выполняют ту же задачу: index() и find().

>>> text.index('Boston')

19

>>> text.find('Boston')

19

В обоих случаях возвращаемое значение — наименьший индекс, где встречаются искомые символы. Разница лишь в поведении функций в случае, если подстрока не была найдена:

>>> text.index('New York')

Traceback (most recent call last):

File "<stdin>", line 1, in <module>

ValueError: substring not found

>>> text.find('New York')

-1

Если index() вернет сообщение с ошибкой, то find() – -1. Также можно посчитать, как часто символ или комбинация из нескольких (подстрока) встречаются в тексте. За это отвечает функция count().

>>> text.count('e')

2

>>> text.count('Avenue')

1

Еще одна доступная операция — замена или удаление подстроки (или отдельного символа). В обоих случаях применяется функция replace(), где удаление подстроки — это то же самое, что и замена ее на пустой символ.

Регулярные выражения

Регулярные выражения предоставляют гибкий способ поиска совпадающих паттернов в тексте. Выражение regex — это строка, написанная с помощью языка регулярных выражений. В Python есть встроенный модуль re, который отвечает за работу с регулярными выражениями.

В первую очередь его нужно импортировать:

>>> import re

Модуль re предоставляет набор функций, которые можно поделить на три категории:

- Поиск совпадающих паттернов

- Замена

- Разбиение

Теперь разберем на примерах. Регулярное выражение для поиска одного или последовательности пробельных символов — \s+. В прошлом разделе вы видели, как для разделения текста на части с помощью split() используется символ разделения. В модуле re есть такая же функция. Она выполняет аналогичную задачу, но в качестве аргумента условия разделения принимает паттерн с регулярным выражением, что делает ее более гибкой.

>>> text = "This is an\t odd \n text!"

>>> re.split('\s+', text)

['This', 'is', 'an', 'odd', 'text!']

Разберемся чуть подробнее с принципом работы модуля re. При вызове функции re.split() сперва компилируется регулярное выражение, а только потом вызывается split() с готовым текстовым аргументом. Можно скомпилировать функцию регулярного выражения с помощью re.compile() и получить объект, который будет использоваться повторно, сэкономив таким образом циклы CPU.

Это особенно важно для операций последовательного поиска подстроки во множестве или массиве строк.

>>> regex = re.compile('\s+')

Создав объект regex с помощью функции compile(), вы сможете прямо использовать split() следующим образом.

>>> regex.split(text)

['This', 'is', 'an', 'odd', 'text!']

Для поиска совпадений паттерна с другими подстроками в тексте используется функция findall(). Она возвращает список всех подстрок, которые соответствуют условиям.

Например, если нужно найти в строке все слова, начинающиеся с латинской «A» в верхнем регистре, или, например, с «a» в любом регистре, необходимо ввести следующее:

>>> text = 'This is my address: 16 Bolton Avenue, Boston'

>>> re.findall('A\w+',text)

['Avenue']

>>> re.findall('[A,a]\w+',text)

['address', 'Avenue']

Есть еще две функции, которые связаны с findall():match() и search(). И если findall() возвращает все совпадения в списке, то search() — только первое. Более того, он является конкретным объектом.

>>> re.search('[A,a]\w+',text)

<_sre.SRE_Match object; span=(11, 18), match='address'>

Этот объект не содержит значение подстроки, соответствующей паттерну, а всего лишь индексы начала и окончания.

>>> search = re.search('[A,a]\w+',text)

>>> search.start()

11

>>> search.end()

18

>>> text[search.start():search.end()]

'address'

Функция match() ищет совпадение в начале строке; если его нет для первого символа, то двигается дальше и ищет в самой строке. Если совпадений не найдено вовсе, то она ничего не вернет.

>>> re.match('[A,a]\w+',text)

В случае успеха же она возвращает то же, что и функция search().

>>> re.match('T\w+',text)

<_sre.SRE_Match object; span=(0, 4), match='This'>

>>> match = re.match('T\w+',text)

>>> text[match.start():match.end()]

'This'

Агрегация данных

Последний этап работы с данными — агрегация. Он включает в себя преобразование, в результате которого из массива получается целое число. На самом деле, ранее упоминаемые функции sum(), mean() и count() — это тоже агрегация. Они работают с наборами данных и выполняют вычисления, результатом которых всегда является одно значение. Однако более формальный способ, дающий больше контроля над агрегацией, включает категоризацию наборов данных.

Категоризация набора, необходимая для группировки, — это важный этап в процессе обработки данных. Это тоже процесс преобразования, ведь после разделения на группы, применяется функция, которая конвертирует или преобразовывает данные определенным образом в зависимости от того, к какой группе они принадлежат. Часто фазы группировки и применения функции происходит в один шаг.

Также для этого этапа анализа данных pandas предоставляет гибкий и производительный инструмент — GroupBy.

Как и в случае с join те, кто знаком с реляционными базами данных и языком SQL, увидят знакомые вещи. Однако языки, такие как SQL, довольно ограничены, когда их применяют к группам. А вот гибкость таких языков, как Python, со всеми доступными библиотеками, особенно pandas, дает возможность выполнять очень сложные операции.

GroupBy

Теперь разберем в подробностях механизм работы GroupBy. Он использует внутренний механизм, процесс под названием split-apply-combine. Это паттерн, который можно разбить на три фазы, выделив отдельные операции:

- Разделение — разделение на группы датасетов

- Применение — применение функции к каждой группе

- Комбинирование — комбинирование результатов разных групп

Рассмотрите процесс подробно на следующей схеме. На первом этапе, разделении, данные из структуры (Dataframe или Series) разделяются на несколько групп в соответствии с заданными критериями: индексами или значениями в колонках. На жаргоне SQL значения в этой колонке называются ключами. Если же вы работаете с двухмерными объектами, такими как Dataframe, критерий группировки может быть применен и к строке (axis = 0), и колонке (axis = 1).

Вторая фаза состоит из применения функции или, если быть точнее, — вычисления, основанного на функции, результатом которого является одно значение, характерное для этой группы.

Последний этап собирает результаты каждой группы и комбинирует их в один объект.

Практический пример

Теперь вы знаете, что процесс агрегации данных в pandas разделен на несколько этапов: разделение-применение-комбинирование. И пусть в библиотеке они не выражены явно конкретными функциями, функция groupby() генерирует объект GroupBy, который является ядром целого процесса.

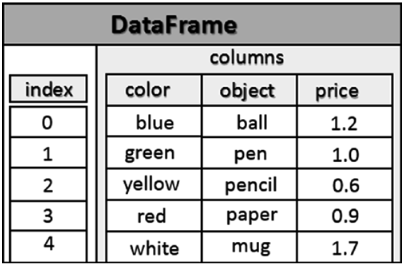

Для лучшего понимания этого механизма стоит обратиться к реальному примеру. Сперва создадим Dataframe с разными числовыми и текстовыми значениями.

>>> frame = pd.DataFrame({ 'color': ['white','red','green','red','green'],

... 'object': ['pen','pencil','pencil','ashtray','pen'],

... 'price1' : [5.56,4.20,1.30,0.56,2.75],

... 'price2' : [4.75,4.12,1.60,0.75,3.15]})

>>> frame

| | color | object | price1 | price2 |

|---|-------|---------|--------|--------|

| 0 | white | pen | 5.56 | 4.75 |

| 1 | red | pencil | 4.20 | 4.12 |

| 2 | green | pencil | 1.30 | 1.60 |

| 3 | red | ashtray | 0.56 | 0.75 |

| 4 | green | pen | 2.75 | 3.15 |

Предположим, нужно посчитать среднюю стоимость в колонке price1 с помощью меток из колонки color. Есть несколько способов, как этого можно добиться. Например, можно получить доступ к колонке price1 и затем вызвать groupby(), где колонка color будет выступать аргументом.

>>> group = frame['price1'].groupby(frame['color'])

>>> group

<pandas.core.groupby.SeriesGroupBy object at 0x00000000098A2A20>

Результат — объект GroupBy. Однако в этой операции не было никаких вычислений; пока что была лишь собрана информация, которая необходима для вычисления среднего значения. Теперь у нас есть group, где все строки с одинаковым значением цвета сгруппированы в один объект.

Чтобы понять, как произошло такое разделение на группы, вызовите атрибут groups для объекта GroupBy.

>>> group.groups

{'green': Int64Index([2, 4], dtype='int64'),

'red': Int64Index([1, 3], dtype='int64'),

'white': Int64Index([0], dtype='int64')}

Как видите, здесь перечислены все группы и явно обозначены строки Dataframe в них. Теперь нужно применить операцию для получения результатов каждой из групп.

>>> group.mean()

color

green 2.025

red 2.380

white 5.560

Name: price1, dtype: float64

>>> group.sum()

color

green 4.05

red 4.76

white 5.56

Name: price1, dtype: float64

Группировка по иерархии

В прошлом разделе данные были сгруппированы по значениям колонки-ключа. Тот же подход можно использовать и для нескольких колонок, сделав группировку нескольких ключей иерархической.

>>> ggroup = frame['price1'].groupby([frame['color'],frame['object']])

>>> ggroup.groups

{('green', 'pen'): Int64Index([4], dtype='int64'),

('green', 'pencil'): Int64Index([2], dtype='int64'),

('red', 'ashtray'): Int64Index([3], dtype='int64'),

('red', 'pencil'): Int64Index([1], dtype='int64'),

('white', 'pen'): Int64Index([0], dtype='int64')}

>>> ggroup.sum()

color object

green pen 2.75

pencil 1.30

red ashtray 0.56

pencil 4.20

white pen 5.56

Name: price1, dtype: float64

Группировка может работать не только с одной колонкой, но и с несколькими или целым Dataframe. Также если объект GroupBy не потребуется использовать несколько раз, просто удобно выполнять группировки и расчеты за раз, без объявления дополнительных переменных.

>>> frame[['price1','price2']].groupby(frame['color']).mean()

| | price1 | price2 |

|-------|--------|--------|

| color | | |

| green | 2.025 | 2.375 |

| red | 2.380 | 2.435 |

| white | 5.560 | 4.750 |

>>> frame.groupby(frame['color']).mean()

| | price1 | price2 |

|-------|--------|--------|

| color | | |

| green | 2.025 | 2.375 |

| red | 2.380 | 2.435 |

| white | 5.560 | 4.750 |

Итерация с группировкой

Объект GroupBy поддерживает операцию итерации для генерации последовательности из двух кортежей, содержащих названия групп и их данных.

>>> for name, group in frame.groupby('color'):

... print(name)

... print(group)

green

color object price1 price2

2 green pencil 1.30 1.60

4 green pen 2.75 3.15

red

color object price1 price2

1 red pencil 4.20 4.12

3 red ashtray 0.56 0.75

white

color object price1 price2

0 white pen 5.56 4.75

В последнем примере для иллюстрации был применен вывод переменных. Но операцию вывода на экран можно заменить на функцию, которую требуется применить.

Цепочка преобразований

Из этих примеров должно стать понятно, что при передаче функциям вычисления или другим операциям группировок (вне зависимости от способа их получения) результатом всегда является Series (если была выбрана одна колонка) или Dataframe, сохраняющий систему индексов и названия колонок.

>>> result1 = frame['price1'].groupby(frame['color']).mean()

>>> type(result1)

<class 'pandas.core.series.Series'>

>>> result2 = frame.groupby(frame['color']).mean()

>>> type(result2)

<class 'pandas.core.frame.DataFrame'>

Таким образом становится возможным выбрать одну колонку на разных этапах процесса. Дальше три примера выбора одной колонки на трех разных этапах. Они иллюстрируют гибкость такой системы группировки в pandas.

>>> frame['price1'].groupby(frame['color']).mean()

color

green 2.025

red 2.380

white 5.560

Name: price1, dtype: float64

>>> frame.groupby(frame['color'])['price1'].mean()

color

green 2.025

red 2.380

white 5.560

Name: price1, dtype: float64

>>> (frame.groupby(frame['color']).mean())['price1']

color

green 2.025

red 2.380

white 5.560

Name: price1, dtype: float64

Но также после операции агрегации имена некоторых колонок могут не нести нужное значение. Поэтому часто оказывается полезным добавлять префикс, объясняющий бизнес-логику такого объединения. Добавление префикса (вместо использования полностью нового имени) помогает отслеживать источник данных. Это важно в случае применения процесса цепочки преобразований (когда Series или Dataframe генерируются друг из друга), где важно отслеживать исходные данные.

>>> means = frame.groupby('color').mean().add_prefix('mean_')

>>> means

| | mean_price1 | mean_price2 |

|-------|-------------|-------------|

| color | | |

| green | 2.025 | 2.375 |

| red | 2.380 | 2.435 |

| white | 5.560 | 4.750 |

Функции для групп

Хотя многие методы не были реализованы специально для GroupBy, они корректно работают с Series. В прошлых примерах было видно, насколько просто получить Series на основе объекта GroupBy, указав имя колонки и применив метод для вычислений. Например, можно использование вычисление квантилей с помощью функции quantiles().

>>> group = frame.groupby('color')

>>> group['price1'].quantile(0.6)

color

green 2.170

red 2.744

white 5.560

Name: price1, dtype: float64

Также можно определять собственные функции агрегации. Для этого функцию нужно создать и передать в качестве аргумента функции mark(). Например, можно вычислить диапазон значений для каждой группы.

>>> def range(series):

... return series.max() - series.min()

...

>>> group['price1'].agg(range)

color

green 1.45

red 3.64

white 0.00

Name: price1, dtype: float64

Функция agg() позволяет использовать функции агрегации для всего объекта Dataframe.

>>> group.agg(range)

| | price1 | price2 |

|-------|--------|--------|

| color | | |

| green | 1.45 | 1.55 |

| red | 3.64 | 3.37 |

| white | 0.00 | 0.00 |

Также можно использовать больше функций агрегации одновременно с помощью mark(), передав массив со списком операций для выполнения. Они станут новыми колонками.

>>> group['price1'].agg(['mean','std',range])

| | mean | std | range |

|-------|-------|----------|-------|

| color | | | |

| green | 2.025 | 1.025305 | 1.45 |

| red | 2.380 | 2.573869 | 3.64 |

| white | 5.560 | NaN | 0.00 |

Продвинутая агрегация данных

В этом разделе речь пойдет о функциях transform() и apply(), которые позволяют выполнять разные виды операций, включая очень сложные.

Предположим, что в одном Dataframe нужно получить следующее: оригинальный объект (с данными) и полученный с помощью вычисления агрегации, например, сложения.

>>> frame = pd.DataFrame({ 'color':['white','red','green','red','green'],

... 'price1':[5.56,4.20,1.30,0.56,2.75],

... 'price2':[4.75,4.12,1.60,0.75,3.15]})

>>> frame

| | color | price1 | price2 |

|---|-------|--------|--------|

| 0 | white | 5.56 | 4.75 |

| 1 | red | 4.20 | 4.12 |

| 2 | green | 1.30 | 1.60 |

| 3 | red | 0.56 | 0.75 |

| 4 | green | 2.75 | 3.15 |

>>> sums = frame.groupby('color').sum().add_prefix('tot_')

>>> sums

| | tot_price1 | tot_price2 | price2 |

|-------|------------|------------|--------|

| color | | | 4.75 |

| green | 4.05 | 4.75 | 4.12 |

| red | 4.76 | 4.87 | 1.60 |

| white | 5.56 | 4.75 | 0.75 |

>>> merge(frame,sums,left_on='color',right_index=True)

| | color | price1 | price2 | tot_price1 | tot_price2 |

|---|-------|--------|--------|------------|------------|

| 0 | white | 5.56 | 4.75 | 5.56 | 4.75 |

| 1 | red | 4.20 | 4.12 | 4.76 | 4.87 |

| 3 | red | 0.56 | 0.75 | 4.76 | 4.87 |

| 2 | green | 1.30 | 1.60 | 4.05 | 4.75 |

| 4 | green | 2.75 | 3.15 | 4.05 | 4.75 |

Благодаря merge() можно сложить результаты агрегации в каждой строке. Но есть и другой способ, работающий за счет transform(). Эта функция выполняет агрегацию, но в то же время показывает значения, сделанные с помощью вычислений на основе ключевого значения в каждой строке Dataframe.

>>> frame.groupby('color').transform(np.sum).add_prefix('tot_')

| | tot_price1 | tot_price2 |

|---|------------|------------|

| 0 | 5.56 | 4.75 |

| 1 | 4.76 | 4.87 |

| 2 | 4.05 | 4.75 |

| 3 | 4.76 | 4.87 |

| 4 | 4.05 | 4.75 |

Метод transform() — более специализированная функция с конкретными условиями: передаваемая в качестве аргумента функция должна возвращать одно скалярное значение (агрегацию).

Метод для более привычных GroupBy — это apply(). Он в полной мере реализует схему разделение-применение-комбинирование. Функция разделяет объект на части для преобразования, вызывает функцию для каждой из частей и затем пытается связать их между собой.

>>> frame = pd.DataFrame( { 'color':['white','black','white','white','black','black'],

... 'status':['up','up','down','down','down','up'],

... 'value1':[12.33,14.55,22.34,27.84,23.40,18.33],

... 'value2':[11.23,31.80,29.99,31.18,18.25,22.44]})

>>> frame

| | color | price1 | price2 | status |

|---|-------|--------|--------|--------|

| 0 | white | 12.33 | 11.23 | up |

| 1 | black | 14.55 | 31.80 | up |

| 2 | white | 22.34 | 29.99 | down |

| 3 | white | 27.84 | 31.18 | down |

| 4 | black | 23.40 | 18.25 | down |

| 5 | black | 18.33 | 22.44 | up |

>>> frame.groupby(['color','status']).apply( lambda x: x.max())

| | | color | price1 | price2 | status |

|-------|--------|-------|--------|--------|--------|

| color | status | | | | |

| black | down | black | 23.40 | 18.25 | down |

| | up | black | 18.33 | 31.80 | up |

| white | down | white | 27.84 | 31.18 | down |

| | up | white | 12.33 | 11.23 | up |

>>> frame.rename(index=reindex, columns=recolumn)

| | color | price1 | price2 | status |

|--------|-------|--------|--------|--------|

| first | white | 12.33 | 11.23 | up |

| second | black | 14.55 | 31.80 | up |

| third | white | 22.34 | 29.99 | down |

| fourth | white | 27.84 | 31.18 | down |

| fifth | black | 23.40 | 18.25 | down |

| 5 | black | 18.33 | 22.44 | up |

>>> temp = pd.date_range('1/1/2015', periods=10, freq= 'H')

>>> temp

DatetimeIndex(['2015-01-01 00:00:00', '2015-01-01 01:00:00',

'2015-01-01 02:00:00', '2015-01-01 03:00:00',

'2015-01-01 04:00:00', '2015-01-01 05:00:00',

'2015-01-01 06:00:00', '2015-01-01 07:00:00',

'2015-01-01 08:00:00', '2015-01-01 09:00:00'],

dtype='datetime64[ns]', freq='H')

>>> timeseries = pd.Series(np.random.rand(10), index=temp)

>>> timeseries

2015-01-01 00:00:00 0.317051

2015-01-01 01:00:00 0.628468

2015-01-01 02:00:00 0.829405

2015-01-01 03:00:00 0.792059

2015-01-01 04:00:00 0.486475

2015-01-01 05:00:00 0.707027

2015-01-01 06:00:00 0.293156

2015-01-01 07:00:00 0.091072

2015-01-01 08:00:00 0.146105

2015-01-01 09:00:00 0.500388

Freq: H, dtype: float64

>>> timetable = pd.DataFrame( {'date': temp, 'value1' : np.random.rand(10),

... 'value2' : np.random.rand(10)})

>>> timetable

| | date | value1 | value2 |

|---|---------------------|----------|----------|

| 0 | 2015-01-01 00:00:00 | 0.125229 | 0.995517 |

| 1 | 2015-01-01 01:00:00 | 0.597289 | 0.160828 |

| 2 | 2015-01-01 02:00:00 | 0.231104 | 0.076982 |

| 3 | 2015-01-01 03:00:00 | 0.862940 | 0.270581 |

| 4 | 2015-01-01 04:00:00 | 0.534056 | 0.306486 |

| 5 | 2015-01-01 05:00:00 | 0.162040 | 0.979835 |

| 6 | 2015-01-01 06:00:00 | 0.400413 | 0.486397 |

| 7 | 2015-01-01 07:00:00 | 0.157052 | 0.246959 |

| 8 | 2015-01-01 08:00:00 | 0.835632 | 0.572664 |

| 9 | 2015-01-01 09:00:00 | 0.812283 | 0.388435 |

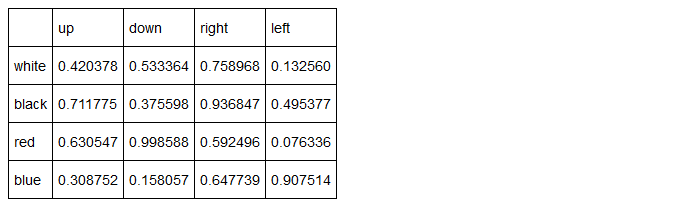

Затем Dataframe добавляется колонка с набором текстовых значений, которые будут выступать ключевыми значениями.

>>> timetable['cat'] = ['up','down','left','left','up','up','down','right',

'right','up']

>>> timetable

| | date | value1 | value2 | cat |

|---|---------------------|----------|----------|-------|

| 0 | 2015-01-01 00:00:00 | 0.125229 | 0.995517 | up |

| 1 | 2015-01-01 01:00:00 | 0.597289 | 0.160828 | down |

| 2 | 2015-01-01 02:00:00 | 0.231104 | 0.076982 | left |

| 3 | 2015-01-01 03:00:00 | 0.862940 | 0.270581 | left |

| 4 | 2015-01-01 04:00:00 | 0.534056 | 0.306486 | up |

| 5 | 2015-01-01 05:00:00 | 0.162040 | 0.979835 | up |

| 6 | 2015-01-01 06:00:00 | 0.400413 | 0.486397 | down |

| 7 | 2015-01-01 07:00:00 | 0.157052 | 0.246959 | right |

| 8 | 2015-01-01 08:00:00 | 0.835632 | 0.572664 | right |

| 9 | 2015-01-01 09:00:00 | 0.812283 | 0.388435 | up |

Но в этом примере все равно есть повторяющиеся ключи.

]]>Процесс подготовки данных для анализа включает сборку данных в Dataframe с возможными добавлениями из других объектов и удалением ненужных частей. Следующий этап — трансформация. После того как данные внутри структуры организованы, нужно преобразовать ее значения. Этот раздел будет посвящен распространенным проблемам и процессам, которые требуются для их решения с помощью функций библиотеки pandas.

Среди них удаление элементов с повторяющимися значениями, изменение индексов, обработка числовых значений данных и строк.

Удаление повторов

Дубликаты строк могут присутствовать в Dataframe по разным причинам. И в объектах особо крупного размера их может быть сложно обнаружить. Для этого в pandas есть инструменты анализа повторяющихся данных для крупных структур.

Для начала создадим простой Dataframe с повторяющимися строками.

>>> dframe = pd.DataFrame({'color': ['white','white','red','red','white'],

... 'value': [2,1,3,3,2]})

>>> dframe

| | color | value |

|---|-------|-------|

| 0 | white | 2 |

| 1 | white | 1 |

| 2 | red | 3 |

| 3 | red | 3 |

| 4 | white | 2 |

Функция duplicated() способна обнаружить дубликаты. Она вернет объект Series, состоящий из булевых значений, где каждый элемент соответствует строке. Их значения равны True, если строка является дубликатом (все повторения за исключением первого) и False, если повторов этого элемента не было.

>>> dframe.duplicated()

0 False

1 False

2 False

3 True

4 True

dtype: bool

Объект с булевыми элементами может быть особенно полезен, например, для фильтрации. Так, чтобы увидеть строки-дубликаты, нужно просто написать следующее:

>>> dframe[dframe.duplicated()]

| | color | value |

|---|-------|-------|

| 3 | red | 3 |

| 4 | white | 2 |

Обычно повторяющиеся строки удаляются. Для этого в pandas есть функция drop_duplicates(), которая возвращает Dataframe без дубликатов.

>>> dframe = dframe.drop_duplicates()

>>> dframe

| | color | value |

|---|-------|-------|

| 0 | white | 2 |

| 2 | red | 3 |

Маппинг

Библиотека pandas предоставляет набор функций, использующих маппинг для выполнения определенных операций. Маппинг — это всего лишь создание списка совпадений двух разных значений, что позволяет привязывать значение определенной метке или строке.

Для определения маппинга лучше всего подходит объект dict:

map = {

'label1' : 'value1,

'label2' : 'value2,

...

}

Функции, которые будут дальше встречаться в этом разделе, выполняют конкретные операции, но всегда принимают объект dict.

• replace() — Заменяет значения

• map() — Создает новый столбец

• rename() — Заменяет значения индекса

Замена значений с помощью маппинга

Часто бывает так, что в готовой структуре данных присутствуют значения, не соответствующие конкретным требованиям. Например, текст может быть написан на другом языке, являться синонимом или, например, выраженным в другом виде. В таких случаях используется операция замены разных значений.

Для примера определим Dataframe с разными объектами и их цветами, включая два названия цветов не на английском.

>>> frame = pd.DataFrame({'item':['ball','mug','pen','pencil','ashtray'],

... 'color':['white','rosso','verde','black','yellow'],

... 'price':[5.56,4.20,1.30,0.56,2.75]})

>>> frame

| | color | item | price |

|---|--------|---------|-------|

| 0 | white | ball | 5.56 |

| 1 | rosso | mug | 4.20 |

| 2 | verde | pen | 1.30 |

| 3 | black | pencil | 0.56 |

| 4 | yellow | ashtray | 2.75 |

Для замены некорректных значений новыми нужно определить маппинг соответствий, где ключами будут выступать новые значения.

>>> newcolors = {

... 'rosso': 'red',

... 'verde': 'green'

... }

Теперь осталось использовать функцию replace(), задав маппинг в качестве аргумента.

>>> frame.replace(newcolors)

| | color | item | price |

|---|--------|---------|-------|

| 0 | white | ball | 5.56 |

| 1 | red | mug | 4.20 |

| 2 | green | pen | 1.30 |

| 3 | black | pencil | 0.56 |

| 4 | yellow | ashtray | 2.75 |

Как видно выше, два цвета были заменены на корректные значения в Dataframe. Распространенный пример — замена значений NaN на другие, например, на 0. Функция replace() отлично справляется и с этим.

>>> ser = pd.Series([1,3,np.nan,4,6,np.nan,3])

>>> ser

0 1.0

1 3.0

2 NaN

3 4.0

4 6.0

5 NaN

6 3.0

dtype: float64

>>> ser.replace(np.nan,0)

0 1.0

1 3.0

2 0.0

3 4.0

4 6.0

5 0.0

6 3.0

dtype: float64

Добавление значений с помощью маппинга

В предыдущем примере вы узнали, как менять значения с помощью маппинга. Теперь попробуем использовать маппинг на другом примере — для добавления новых значений в колонку на основе значений в другой. Маппинг всегда определяется отдельно.

>>> frame = pd.DataFrame({'item':['ball','mug','pen','pencil','ashtray'],

... 'color':['white','red','green','black','yellow']})

>>> frame

| | color | item |

|---|--------|---------|

| 0 | white | ball |

| 1 | red | mug |

| 2 | green | pen |

| 3 | black | pencil |

| 4 | yellow | ashtray |

Предположим, что нужно добавить колонку с ценой вещи из объекта. Также предположим, что имеется список цен. Определим его в виде объекта dict с ценами для каждого типа объекта.

>>> prices = {

... 'ball' : 5.56,

... 'mug' : 4.20,

... 'bottle' : 1.30,

... 'scissors' : 3.41,

... 'pen' : 1.30,

... 'pencil' : 0.56,

... 'ashtray' : 2.75

... }

Функция map(), примененная к Series или колонке объекта Dataframe принимает функцию или объект с маппингом dict. В этому случае можно применить маппинг цен для элементов колонки, добавив еще одну колонку price в Dataframe.

>>> frame['price'] = frame['item'].map(prices)

>>> frame

| | color | item | price |

|---|--------|---------|-------|

| 0 | white | ball | 5.56 |

| 1 | red | mug | 4.20 |

| 2 | green | pen | 1.30 |

| 3 | black | pencil | 0.56 |

| 4 | yellow | ashtray | 2.75 |

Переименование индексов осей

По примеру того, как работает изменение значений в Series и Dataframe, можно трансформировать метки оси с помощью маппинга. Для замены меток индексов в pandas есть функция rename(), которая принимает маппинг (объект dict) в качестве аргумента.

>>> frame

| | color | item | price |

|---|--------|---------|-------|

| 0 | white | ball | 5.56 |

| 1 | red | mug | 4.20 |

| 2 | green | pen | 1.30 |

| 3 | black | pencil | 0.56 |

| 4 | yellow | ashtray | 2.75 |

>>> reindex = {

... 0: 'first',

... 1: 'second',

... 2: 'third',

... 3: 'fourth',

... 4: 'fifth'}

>>> frame.rename(reindex)

| | color | item | price |

|--------|--------|---------|-------|

| first | white | ball | 5.56 |

| second | red | mug | 4.20 |

| third | green | pen | 1.30 |

| fourth | black | pencil | 0.56 |

| fifth | yellow | ashtray | 2.75 |

По умолчанию переименовываются индексы. Если же нужно поменять названия колонок, то используется параметр columns. В следующем примере присвоим несколько маппингов двум индексам с параметром columns.

>>> recolumn = {

... 'item':'object',

... 'price': 'value'}

>>> frame.rename(index=reindex, columns=recolumn)

| | color | object | price |

|--------|--------|---------|-------|

| first | white | ball | 5.56 |

| second | red | mug | 4.20 |

| third | green | pen | 1.30 |

| fourth | black | pencil | 0.56 |

| fifth | yellow | ashtray | 2.75 |

В тех случаях когда заменить нужно только одно значение, все можно и не писать.

>>> frame.rename(index={1:'first'}, columns={'item':'object'})

| | color | object | price |

|-------|--------|---------|-------|

| 0 | white | ball | 5.56 |

| first | red | mug | 4.20 |

| 2 | green | pen | 1.30 |

| 3 | black | pencil | 0.56 |

| 4 | yellow | ashtray | 2.75 |

Пока что функция rename() возвращала объект Dataframe с изменениями, не трогая оригинальный объект. Но если нужно поменять его, то необходимо передать значение True параметру inplace.

>>> frame.rename(columns={'item':'object'}, inplace=True)

>>> frame

| | color | object | price |

|---|--------|---------|-------|

| 0 | white | ball | 5.56 |

| 1 | red | mug | 4.20 |

| 2 | green | pen | 1.30 |

| 3 | black | pencil | 0.56 |

| 4 | yellow | ashtray | 2.75 |

Дискретизация и биннинг

Более сложный процесс преобразования называется дискретизацией. Он используется для обработки большим объемов данных. Для анализа их необходимо разделять на дискретные категории, например, распределив диапазон значений на меньшие интервалы и посчитав статистику для каждого. Еще один пример — большое количество образцов. Даже здесь необходимо разделять весь диапазон по категориям и внутри них считать вхождения и статистику.

В следующем случае, например, нужно работать с экспериментальными значениями, лежащими в диапазоне от 0 до 100. Эти данные собраны в список.

>>> results = [12,34,67,55,28,90,99,12,3,56,74,44,87,23,49,89,87]

Вы знаете, что все значения лежат в диапазоне от 0 до 100, а это значит, что их можно разделить на 4 одинаковых части, бины. В первом будут элементы от 0 до 25, во втором — от 26 до 50, в третьем — от 51 до 75, а в последнем — от 75 до 100.

Для этого в pandas сначала нужно определить массив со значениями разделения:

>>> bins = [0,25,50,75,100]

Затем используется специальная функция cut(), которая применяется к массиву. В нее нужно добавить и бины.

>>> cat = pd.cut(results, bins)

>>> cat

(0, 25]

(25, 50]

(50, 75]

(50, 75]

(25, 50]

(75, 100]

(75, 100]

(0, 25]

(0, 25]

(50, 75]

(50, 75]

(25, 50]

(75, 100]

(0, 25]

(25, 50]

(75, 100]

(75, 100]

Levels (4): Index(['(0, 25]', '(25, 50]', '(50, 75]', '(75, 100]'],

dtype=object)

Функция cut() возвращает специальный объект типа Categorical. Его можно считать массивом строк с названиями бинов. Внутри каждая содержит массив categories, включающий названия разных внутренних категорий и массив codes со списком чисел, равных элементам results. Число соответствует бину, которому был присвоен соответствующий элемент results.

>>> cat.categories

IntervalIndex([0, 25], (25, 50], (50, 75], (75, 100]]

closed='right'

dtype='interval[int64]')

>>> cat.codes

array([0, 1, 2, 2, 1, 3, 3, 0, 0, 2, 2, 1, 3, 0, 1, 3, 3], dtype=int8)

Чтобы узнать число вхождений каждого бина, то есть, результаты для всех категорий, нужно использовать функцию value_counts().

>>> pd.value_counts(cat)

(75, 100] 5

(50, 75] 4

(25, 50] 4

(0, 25] 4

dtype: int64

У каждого класса есть нижний предел с круглой скобкой и верхний — с квадратной. Такая запись соответствует математической, используемой для записи интервалов. Если скобка квадратная, то число лежит в диапазоне, а если круглая — то нет.

Бинам можно задавать имена, передав их в массив строк, а затем присвоив его параметру labels в функции cut(), которая используется для создания объекта Categorical.

>>> bin_names = ['unlikely','less likely','likely','highly likely']

>>> pd.cut(results, bins, labels=bin_names)

unlikely

less likely

likely

likely

less likely

highly likely

highly likely

unlikely

unlikely

likely

likely

less likely

highly likely

unlikely

less likely

highly likely

highly likely

Levels (4): Index(['unlikely', 'less likely', 'likely', 'highly likely'],

dtype=object)

Если функции cut() передать в качестве аргумента целое число, а не границы бина, то диапазон значений будет разделен на указанное количество интервалов.

Пределы будут основаны на минимуме и максимуме данных.

>>> pd.cut(results, 5)

(2.904, 22.2]

(22.2, 41.4]

(60.6, 79.8]

(41.4, 60.6]

(22.2, 41.4]

(79.8, 99]

(79.8, 99]

(2.904, 22.2]

(2.904, 22.2]

(41.4, 60.6]

(60.6, 79.8]

(41.4, 60.6]

(79.8, 99]

(22.2, 41.4]

(41.4, 60.6]

(79.8, 99]

(79.8, 99]

Levels (5): Index(['(2.904, 22.2]', '(22.2, 41.4]', '(41.4, 60.6]',

'(60.6, 79.8]', '(79.8, 99]'], dtype=object)

Также в pandas есть еще одна функция для биннинга, qcut(). Она делит весь набор на квантили. Так, в зависимости от имеющихся данных cut() обеспечит разное количество данных для каждого бина. А qcut() позаботится о том, чтобы количество вхождений было одинаковым. Могут отличаться только границы.

>>> quintiles = pd.qcut(results, 5)

>>> quintiles

[3, 24]

(24, 46]

(62.6, 87]

(46, 62.6]

(24, 46]

(87, 99]

(87, 99]

[3, 24]

[3, 24]

(46, 62.6]

(62.6, 87]

(24, 46]

(62.6, 87]

[3, 24]

(46, 62.6]

(87, 99]

(62.6, 87]

Levels (5): Index(['[3, 24]', '(24, 46]', '(46, 62.6]', '(62.6, 87]',

'(87, 99]'], dtype=object)

>>> pd.value_counts(quintiles)

[3, 24] 4

(62.6, 87] 4

(87, 99] 3

(46, 62.6] 3

(24, 46] 3

dtype: int64

В этом примере видно, что интервалы отличаются от тех, что получились в результате использования функции cut(). Также можно обратить внимание на то, что qcut() попыталась стандартизировать вхождения для каждого бина, поэтому в первых двух больше вхождений. Это связано с тем, что количество объектов не делится на 5.

Определение и фильтрация лишних данных

При анализе данных часто приходится находить аномальные значения в структуре данных. Для примера создайте Dataframe с тремя колонками целиком случайных чисел.

>>> randframe = pd.DataFrame(np.random.randn(1000,3))

С помощью функции describe() можно увидеть статистику для каждой колонки.

>>> randframe.describe()

| | 0 | 1 | 2 |

|-------|-------------|-------------|-------------|

| count | 1000.000000 | 1000.000000 | 1000.000000 |

| mean | -0.036163 | 0.037203 | 0.018722 |

| std | 1.038703 | 0.986338 | 1.011587 |

| min | -3.591217 | -3.816239 | -3.586733 |

| 25% | -0.729458 | -0.581396 | -0.665261 |

| 50% | -0.025864 | 0.005155 | -0.002774 |

| 75% | 0.674396 | 0.706958 | 0.731404 |

| max | 3.115554 | 2.899073 | 3.425400 |

Лишними можно считать значения, которые более чем в три раза больше стандартного отклонения. Чтобы оставить только подходящие, нужно использовать функцию std().

>>> randframe.std()

0 1.038703

1 0.986338

2 1.011587

dtype: float64

Теперь используйте фильтр для всех значений Dataframe, применив соответствующее стандартное отклонение для каждой колонки. Функция any() позволит использовать фильтр для каждой колонки.

>>> randframe[(np.abs(randframe) > (3*randframe.std())).any(1)]

| | 0 | 1 | 2 |

|-----|-----------|-----------|-----------|

| 87 | -2.106846 | -3.408329 | -0.067435 |

| 129 | -3.591217 | 0.791474 | 0.243038 |

| 133 | 1.149396 | -3.816239 | 0.328653 |

| 717 | 0.434665 | -1.248411 | -3.586733 |

| 726 | 1.682330 | 1.252479 | -3.090042 |

| 955 | 0.272374 | 2.224856 | 3.425400 |

Перестановка

Операции перестановки (случайного изменения порядка) в объекте Series или строках Dataframe можно выполнить с помощью функции numpy.random.permutation().

Для этого примера создайте Dataframe с числами в порядке возрастания.

>>> nframe = pd.DataFrame(np.arange(25).reshape(5,5))

>>> nframe

| | 0 | 1 | 2 | 3 | 4 |

|---|----|----|----|----|----|

| 0 | 0 | 1 | 2 | 3 | 4 |

| 1 | 5 | 6 | 7 | 8 | 9 |

| 2 | 10 | 11 | 12 | 13 | 14 |

| 3 | 15 | 16 | 17 | 18 | 19 |

| 4 | 20 | 21 | 22 | 23 | 24 |

Теперь создайте массив из пяти чисел от 0 до 4 в случайном порядке с функцией permutation(). Этот массив будет новым порядком, в котором потребуется разместить и значения строк из Dataframe.

>>> new_order = np.random.permutation(5)

>>> new_order

array([2, 3, 0, 1, 4])

Теперь примените его ко всем строкам Dataframe с помощью функции take().

>>> nframe.take(new_order)

| | 0 | 1 | 2 | 3 | 4 |

|---|----|----|----|----|----|

| 2 | 10 | 11 | 12 | 13 | 14 |

| 3 | 15 | 16 | 17 | 18 | 19 |

| 0 | 0 | 1 | 2 | 3 | 4 |

| 4 | 20 | 21 | 22 | 23 | 24 |

| 1 | 5 | 6 | 7 | 8 | 9 |

Как видите, порядок строк поменялся, а индексы соответствуют порядку в массиве new_order.

Перестановку можно произвести и для отдельной части Dataframe. Это сгенерирует массив с последовательностью, ограниченной конкретным диапазоном, например, от 2 до 4.

>>> new_order = [3,4,2]

>>> nframe.take(new_order)

| | 0 | 1 | 2 | 3 | 4 |

|---|----|----|----|----|----|

| 3 | 15 | 16 | 17 | 18 | 19 |

| 4 | 20 | 21 | 22 | 23 | 24 |

| 2 | 10 | 11 | 12 | 13 | 14 |

Случайная выборка

Вы уже знаете, как доставать отдельные части Dataframe для последующей перестановки. Но иногда ее потребуется отобрать случайным образом. Проще всего сделать это с помощью функции np.random.randint().

>>> sample = np.random.randint(0, len(nframe), size=3)

>>> sample

array([1, 4, 4])

>>> nframe.take(sample)

| | 0 | 1 | 2 | 3 | 4 |

|---|----|----|----|----|----|

| 3 | 15 | 16 | 17 | 18 | 19 |

| 3 | 15 | 16 | 17 | 18 | 19 |

| 3 | 15 | 16 | 17 | 18 | 19 |

В этом случае один и тот же участок попадается даже чаще.

]]>Прежде чем приступать к работе с данными, их нужно подготовить и собрать в виде структуры, так чтобы они поддавались обработке с помощью инструментов из библиотеки pandas. Дальше перечислены некоторые из этапов подготовки.

- Загрузка

- Сборка

- Объединение (merge)

- Конкатенация (concatenating)

- Комбинирование (combining)

- Изменение

- Удаление

Прошлый материал был посвящен загрузке. На этом этапе происходит конвертация из разных форматов в одну структуру данных, такую как Dataframe. Но даже после этого требуются дополнительные этапы подготовки. Поэтому дальше речь пойдет о том, как выполнять операции получения данных в объединенной структуре данных.

Данные из объектов pandas можно собрать несколькими путями:

- Объединение — функция

pandas.merge()соединяет строки вDataframeна основе одного или нескольких ключей. Этот вариант будет знаком всем, кто работал с языком SQL, поскольку там есть аналогичная операция. - Конкатенация — функция

pandas.concat()конкатенирует объекты по оси. - Комбинирование — функция

pandas.DataFrame.combine_first()является методом, который позволяет соединять пересекающиеся данные для заполнения недостающих значений в структуре, используя данные другой структуры.

Более того, частью подготовки является поворот — процесс обмена строк и колонок.

Соединение

Операция соединения (merge), которая соответствует JOIN из SQL, состоит из объединения данных за счет соединения строк на основе одного или нескольких ключей.

На самом деле, любой, кто работал с реляционными базами данных, обычно использует запрос JOIN из SQL для получения данных из разных таблиц с помощью ссылочных значений (ключей) внутри них. На основе этих ключей можно получать новые данные в табличной форме как результат объединения других таблиц. Эта операция в библиотеке pandas называется соединением (merging), а merge() — функция для ее выполнения.

Сначала нужно импортировать библиотеку pandas и определить два объекта Dataframe, которые будут примерами в этом разделе.

>>> import numpy as np

>>> import pandas as pd

>>> frame1 = pd.DataFrame({'id':['ball','pencil','pen','mug','ashtray'],

... 'price': [12.33,11.44,33.21,13.23,33.62]})

>>> frame1

| | id | price |

|---|---------|-------|

| 0 | ball | 12.33 |

| 1 | pencil | 11.44 |

| 2 | pen | 33.21 |

| 3 | mug | 13.23 |

| 4 | ashtray | 33.62 |

>>> frame2 = pd.DataFrame({'id':['pencil','pencil','ball','pen'],

... 'color': ['white','red','red','black']})

>>> frame2

| | color | id |

|---|-------|--------|

| 0 | white | pencil |

| 1 | red | pencil |

| 2 | red | ball |

| 3 | black | pen |

Выполним соединение, применив функцию merge() к двум объектам.

>>> pd.merge(frame1,frame2)

| | id | price | color |

|---|--------|-------|-------|

| 0 | ball | 12.33 | red |

| 1 | pencil | 11.44 | white |

| 2 | pencil | 11.44 | red |

| 3 | pen | 33.21 | black |

Получившийся объект Dataframe состоит из всех строк с общим ID. В дополнение к общей колонке добавлены и те, что присутствуют только в первом и втором объектах.

В этом случае функция merge() была использована без явного определения колонок. Но чаще всего необходимо указывать, на основе какой колонки выполнять соединение.

Для этого нужно добавить свойство с названием колонки, которое будет ключом соединения.

>>> frame1 = pd.DataFrame({'id':['ball','pencil','pen','mug','ashtray'],

... 'color': ['white','red','red','black','green'],

... 'brand': ['OMG','ABC','ABC','POD','POD']})

>>> frame1

| | brand | color | id |

|---|-------|-------|---------|

| 0 | OMG | white | ball |

| 1 | ABC | red | pencil |

| 2 | ABC | red | pen |

| 3 | POD | black | mug |

| 4 | PPOD | green | ashtray |

>>> frame2 = pd.DataFrame({'id':['pencil','pencil','ball','pen'],

... 'brand': ['OMG','POD','ABC','POD']})

>>> frame2

| | brand | id |

|---|-------|--------|

| 0 | OMG | pencil |

| 1 | POD | pencil |

| 2 | ABC | ball |

| 3 | POD | pen |

В этом случае два объекта Dataframe имеют колонки с одинаковыми названиями. Поэтому при запуске merge результата не будет.

>>> pd.merge(frame1,frame2)

Empty DataFrame

Columns: [brand, color, id]

Index: []

Необходимо явно задавать условия соединения, которым pandas будет следовать, определяя название ключа в параметре on.

>>> pd.merge(frame1,frame2,on='id')

| | brand_x | color | id | brand_y |

|---|---------|-------|--------|---------|

| 0 | OMG | white | ball | ABC |

| 1 | ABC | red | pencil | OMG |

| 2 | ABC | red | pencil | POD |

| 3 | ABC | red | pen | POD |

>>> pd.merge(frame1,frame2,on='brand')

| | brand | color | id_x | id_y |

|---|-------|-------|--------|--------|

| 0 | OMG | white | ball | pencil |

| 1 | ABC | red | pencil | ball |

| 2 | ABC | red | pen | ball |

| 3 | POD | black | mug | pencil |

| 4 | POD | black | mug | pen |

Как и ожидалось, результаты отличаются в зависимости от условий соединения.

Но часто появляется другая проблема, когда есть два Dataframe без колонок с одинаковыми названиями. Для исправления ситуации нужно использовать left_on и right_on, которые определяют ключевые колонки для первого и второго объектов Dataframe. Дальше следует пример.

>>> frame2.columns = ['brand','sid']

>>> frame2

| | brand | sid |

|---|-------|--------|

| 0 | OMG | pencil |

| 1 | POD | pencil |

| 2 | ABC | ball |

| 3 | POD | pen |

>>> pd.merge(frame1, frame2, left_on='id', right_on='sid')

| | brand_x | color | id | brand_y | sid |

|---|---------|-------|--------|---------|--------|

| 0 | OMG | white | ball | ABC | ball |

| 1 | ABC | red | pencil | OMG | pencil |

| 2 | ABC | red | pencil | POD | pencil |

| 3 | ABC | red | pen | POD | pen |

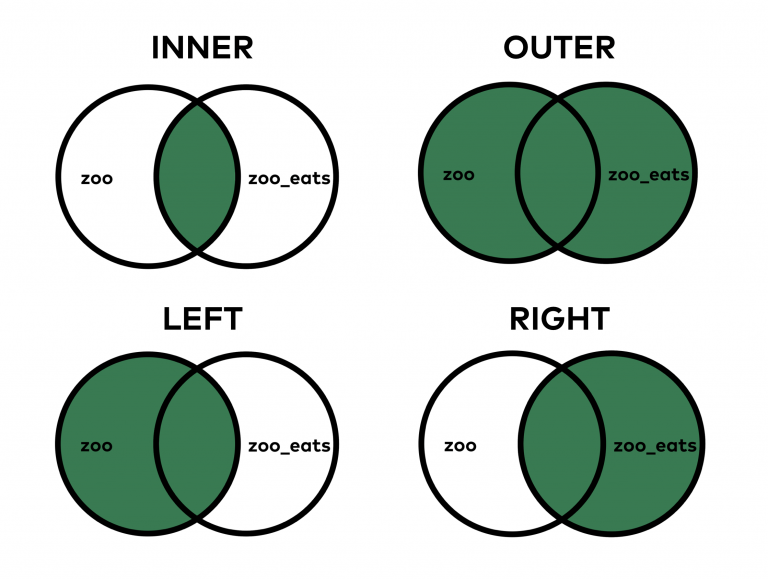

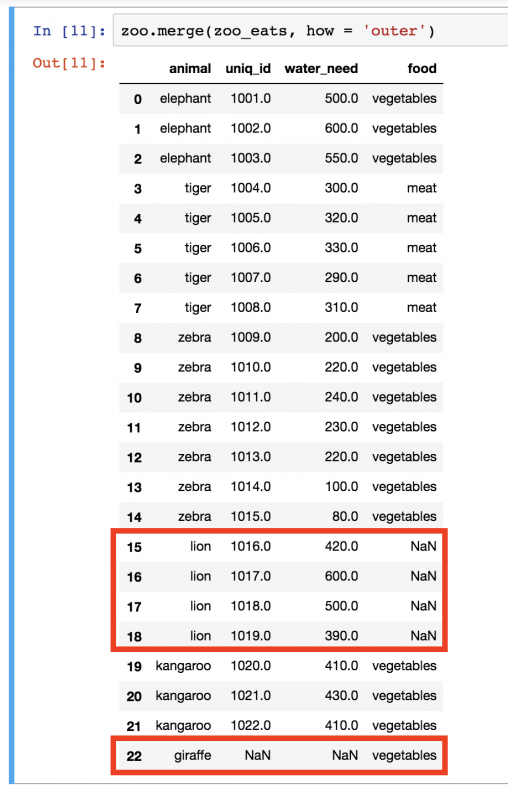

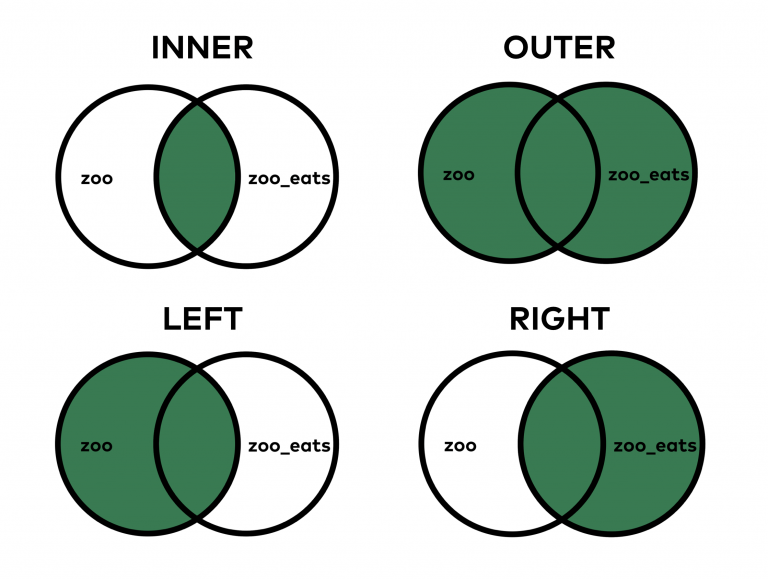

По умолчанию функция merge() выполняет inner join (внутреннее соединение). Ключ в финальном объекте — результат пересечения.

Другие возможные варианты: left join, right join и outer join (левое, правое и внешнее соединение). Внешнее выполняет объединение всех ключей, комбинируя эффекты правого и левого соединений. Для выбора типа нужно использовать параметр how.

>>> frame2.columns = ['brand','id']

>>> pd.merge(frame1,frame2,on='id')

| | brand_x | color | id | brand_y |

|---|---------|-------|--------|---------|

| 0 | OMG | white | ball | ABC |

| 1 | ABC | red | pencil | OMG |

| 2 | ABC | red | pencil | POD |

| 3 | ABC | red | pen | POD |

>>> pd.merge(frame1,frame2,on='id',how='outer')

| | brand_x | color | id | brand_y |

|---|---------|-------|---------|---------|

| 0 | OMG | white | ball | ABC |

| 1 | ABC | red | pencil | OMG |

| 2 | ABC | red | pencil | POD |

| 3 | ABC | red | pen | POD |

| 4 | POD | black | mug | NaN |

| 5 | PPOD | green | ashtray | NaN |

>>> pd.merge(frame1,frame2,on='id',how='left')

| | brand_x | color | id | brand_y |

|---|---------|-------|---------|---------|

| 0 | OMG | white | ball | ABC |

| 1 | ABC | red | pencil | OMG |

| 2 | ABC | red | pencil | POD |

| 3 | ABC | red | pen | POD |

| 4 | POD | black | mug | NaN |

| 5 | PPOD | green | ashtray | NaN |

>>> pd.merge(frame1,frame2,on='id',how='right')

| | brand_x | color | id | brand_y |

|---|---------|-------|--------|---------|

| 0 | OMG | white | ball | ABC |

| 1 | ABC | red | pencil | OMG |

| 2 | ABC | red | pencil | POD |

| 3 | ABC | red | pen | POD |

>>> pd.merge(frame1,frame2,on=['id','brand'],how='outer')

| | brand | color | id |

|---|-------|-------|---------|

| 0 | OMG | white | ball |

| 1 | ABC | red | pencil |

| 2 | ABC | red | pen |

| 3 | POD | black | mug |

| 4 | PPOD | green | ashtray |

| 5 | OMG | NaN | pencil |

| 6 | POD | NaN | pencil |

| 7 | ABC | NaN | ball |

| 8 | POD | NaN | pen |

Для соединения нескольких ключей, нужно просто в параметр on добавить список.

Соединение по индексу

В некоторых случаях вместо использования колонок объекта Dataframe в качестве ключей для этих целей можно задействовать индексы. Затем для выбора конкретных индексов нужно задать значения True для left_join или right_join. Они могут быть использованы и вместе.

>>> pd.merge(frame1,frame2,right_index=True, left_index=True)

| | brand_x | color | id_x | brand_y | id_y |

|---|---------|-------|--------|---------|--------|

| 0 | OMG | white | ball | OMG | pencil |

| 1 | ABC | red | pencil | POD | pencil |

| 2 | ABC | red | pen | ABC | ball |

| 3 | POD | black | mug | POD | pen |

Но у объектов Dataframe есть и функция join(), которая оказывается особенно полезной, когда необходимо выполнить соединение по индексам. Она же может быть использована для объединения множества объектов с одинаковыми индексами, но без совпадающих колонок.

При запуске такого кода

>>> frame1.join(frame2)

Будет ошибка, потому что некоторые колонки в объекте frame1 называются так же, как и во frame2. Нужно переименовать их во втором объекте перед использованием join().

>>> frame2.columns = ['brand2','id2']

>>> frame1.join(frame2)

В этом примере соединение было выполнено на основе значений индексов, а не колонок. Также индекс 4 представлен только в объекте frame1, но соответствующие значения колонок во frame2 равняются NaN.

Конкатенация

Еще один тип объединения данных — конкатенация. NumPy предоставляет функцию concatenate() для ее выполнения.

>>> array1 = np.arange(9).reshape((3,3))

>>> array1

array([[0, 1, 2],

[3, 4, 5],

[6, 7, 8]])

>>> array2 = np.arange(9).reshape((3,3))+6

>>> array2

array([[6, 7, 8],

[9, 10, 11],

[12, 13, 14]])

>>> np.concatenate([array1,array2],axis=1)

array([[0, 1, 2, 6, 7, 8],

[3, 4, 5, 9, 10, 11],

[6, 7, 8, 12, 13, 14]])

>>> np.concatenate([array1,array2],axis=0)

array([[0, 1, 2],

[3, 4, 5],

[6, 7, 8],

[6, 7, 8],

[9, 10, 11],

[12, 13, 14]])

С библиотекой pandas и ее структурами данных, такими как Series и Dataframe, именованные оси позволяют и дальше обобщать конкатенацию массивов. Для этого в pandas есть функция concat().

>>> ser1 = pd.Series(np.random.rand(4), index=[1,2,3,4])

>>> ser1

1 0.636584

2 0.345030

3 0.157537

4 0.070351

dtype: float64

>>> ser2 = pd.Series(np.random.rand(4), index=[5,6,7,8])

>>> ser2

5 0.411319

6 0.359946

7 0.987651

8 0.329173

dtype: float64

>>> pd.concat([ser1,ser2])

1 0.636584

2 0.345030

3 0.157537

4 0.070351

5 0.411319

6 0.359946

7 0.987651

8 0.329173

dtype: float64

По умолчанию функция concat() работает на axis=0 и возвращает объект Series. Если задать 1 значением axis, то результатом будет объект Dataframe.

>>> pd.concat([ser1,ser2],axis=1)

| | 0 | 1 |

|---|----------|----------|

| 1 | 0.953608 | NaN |

| 2 | 0.929539 | NaN |

| 3 | 0.036994 | NaN |

| 4 | 0.010650 | NaN |

| 5 | NaN | 0.200771 |

| 6 | NaN | 0.709060 |

| 7 | NaN | 0.813766 |

| 8 | NaN | 0.218998 |

Проблема с этой операцией в том, что конкатенированные части не определяются в итоговом объекте. Например, нужно создать иерархический индекс на оси конкатенации. Для этого требуется использовать параметр keys.

>>> pd.concat([ser1,ser2], keys=[1,2])

1 1 0.953608

2 0.929539

3 0.036994

4 0.010650

2 5 0.200771

6 0.709060

7 0.813766

8 0.218998

dtype: float64

В случае объединения двух Series по axis=1 ключи становятся заголовками колонок объекта Dataframe.

>>> pd.concat([ser1,ser2], axis=1, keys=[1,2])

| | 1 | 2 |

|---|----------|----------|

| 1 | 0.953608 | NaN |

| 2 | 0.929539 | NaN |

| 3 | 0.036994 | NaN |

| 4 | 0.010650 | NaN |

| 5 | NaN | 0.200771 |

| 6 | NaN | 0.709060 |

| 7 | NaN | 0.813766 |

| 8 | NaN | 0.218998 |

Пока что в примерах конкатенация применялась только к объектам Series, но та же логика работает и с Dataframe.

>>> frame1 = pd.DataFrame(np.random.rand(9).reshape(3,3),

... index=[1,2,3], columns=['A','B','C'])

>>> frame2 = pd.DataFrame(np.random.rand(9).reshape(3,3),

... index=[4,5,6], columns=['A','B','C'])

>>> pd.concat([frame1, frame2])

| | A | B | C |

|---|----------|----------|----------|

| 1 | 0.231057 | 0.024329 | 0.843888 |

| 2 | 0.727480 | 0.296619 | 0.367309 |

| 3 | 0.282516 | 0.524227 | 0.462000 |

| 4 | 0.078044 | 0.751505 | 0.832853 |

| 5 | 0.843225 | 0.945914 | 0.141331 |

| 6 | 0.189217 | 0.799631 | 0.308749 |

>>> pd.concat([frame1, frame2], axis=1)

| | A | B | C | A | B | C |

|---|----------|----------|----------|----------|----------|----------|

| 1 | 0.231057 | 0.024329 | 0.843888 | NaN | NaN | NaN |

| 2 | 0.727480 | 0.296619 | 0.367309 | NaN | NaN | NaN |

| 3 | 0.282516 | 0.524227 | 0.462000 | NaN | NaN | NaN |

| 4 | NaN | NaN | NaN | 0.078044 | 0.751505 | 0.832853 |

| 5 | NaN | NaN | NaN | 0.843225 | 0.945914 | 0.141331 |

| 6 | NaN | NaN | NaN | 0.189217 | 0.799631 | 0.308749 |

Комбинирование

Есть еще одна ситуация, при которой объединение не работает за счет соединения или конкатенации. Например, если есть два набора данных с полностью или частично пересекающимися индексами.

Одна из функций для Series называется combine_first(). Она выполняет объединение с выравниваем данных.

>>> ser1 = pd.Series(np.random.rand(5),index=[1,2,3,4,5])

>>> ser1

1 0.075815

2 0.332282

3 0.884463

4 0.518336

5 0.089025

dtype: float64

>>> ser2 = pd.Series(np.random.rand(4),index=[2,4,5,6])

>>> ser2

2 0.315847

4 0.275937

5 0.352538

6 0.865549

dtype: float64

>>> ser1.combine_first(ser2)

1 0.075815

2 0.332282

3 0.884463

4 0.518336

5 0.089025

6 0.865549

dtype: float64

>>> ser2.combine_first(ser1)

1 0.075815

2 0.315847

3 0.884463

4 0.275937

5 0.352538

6 0.865549

dtype: float64

Если же требуется частичное пересечение, необходимо обозначить конкретные части Series.

>>> ser1[:3].combine_first(ser2[:3])

1 0.075815

2 0.332282

3 0.884463

4 0.275937

5 0.352538

dtype: float64

Pivoting — сводные таблицы

В дополнение к сборке данных для унификации собранных из разных источников значений часто применяется операция поворота. На самом деле, выравнивание данных по строке и колонке не всегда подходит под конкретную ситуацию. Иногда требуется перестроить данные по значениям колонок в строках или наоборот.

Поворот с иерархическим индексированием

Вы уже знаете, что Dataframe поддерживает иерархическое индексирование. Эта особенность может быть использована для перестраивания данных в объекте Dataframe. В контексте поворота есть две базовые операции:

- Укладка (stacking) — поворачивает структуру данных, превращая колонки в строки

- Обратный процесс укладки (unstacking) — конвертирует строки в колонки

>>> frame1 = pd.DataFrame(np.arange(9).reshape(3,3),

... index=['white','black','red'],

... columns=['ball','pen','pencil'])

>>> frame1

| | ball | pen | pencil |

|-------|------|-----|--------|

| white | 0 | 1 | 2 |

| black | 3 | 4 | 5 |

| red | 6 | 7 | 8 |

С помощью функции stack() в Dataframe можно развернуть данные и превратить колонки в строки, получив Series:

>>> ser5 = frame1.stack()

white ball 0

pen 1

pencil 2

black ball 3

pen 4

pencil 5

red ball 6

pen 7

pencil 8

dtype: int32

Из объекта Series с иерархическим индексировании можно выполнить пересборку в развернутую таблицу с помощью unstack().

>>> ser5.unstack()

| | ball | pen | pencil |

|-------|------|-----|--------|

| white | 0 | 1 | 2 |

| black | 3 | 4 | 5 |

| red | 6 | 7 | 8 |

Обратный процесс можно выполнить и на другом уровне, определив количество уровней или название в качестве аргумента функции.

>>> ser5.unstack(0)

| | white | black | red |

|--------|-------|-------|-----|

| ball | 0 | 3 | 6 |

| pen | 1 | 4 | 7 |

| pencil | 2 | 5 | 8 |

Поворот из «длинного» в «широкий» формат

Наиболее распространенный способ хранения наборов данных — точная регистрация данных, которые будут заполнять строки текстового файла: CSV или таблицы в базе данных. Это происходит особенно в таких случаях: чтение выполняется с помощью инструментов; результаты вычислений итерируются; или данные вводятся вручную. Похожий пример таких файлов — логи, заполняемые строка за строкой с помощью постоянно поступающих данных.

Необычная особенность этого типа набора данных — элементы разных колонок, часто повторяющиеся в последующих строках. Они всегда в табличной форме, поэтому их можно воспринимать как формат длинных или упакованных.

Чтобы лучше разобраться с этой концепцией, рассмотрим следующий Dataframe.

>>> longframe = pd.DataFrame({'color':['white','white','white',

... 'red','red','red',

... 'black','black','black'],

... 'item':['ball','pen','mug',

... 'ball','pen','mug',

... 'ball','pen','mug'],

... 'value': np.random.rand(9)})

>>> longframe

| | color | item | value |

|---|-------|------|----------|

| 0 | white | ball | 0.896313 |

| 1 | white | pen | 0.344864 |

| 2 | white | mug | 0.101891 |

| 3 | red | ball | 0.697267 |

| 4 | red | pen | 0.852835 |

| 5 | red | mug | 0.145385 |

| 6 | black | ball | 0.738799 |

| 7 | black | pen | 0.783870 |

| 8 | black | mug | 0.017153 |

Этот режим записи данных имеет свои недостатки. Первый — повторение некоторых полей. Если воспринимать колонки в качестве ключей, то данные в этом формате будет сложно читать, а особенно — понимать отношения между значениями ключей и остальными колонками.

Но существует замена для длинного формата — широкий способ организации данных в таблице. В таком режиме данные легче читать, а также налаживать связь между таблицами. Плюс, они занимают меньше места. Это более эффективный способ хранения данных, пусть и менее практичный, особенно на этапе заполнения объекта данными.

В качестве критерия нужно выбрать колонку или несколько из них как основной ключ. Значения в них должны быть уникальными.

pandas предоставляет функцию, которая позволяет выполнить трансформацию Dataframe из длинного типа в широкий. Она называется pivot(), а в качестве аргументов принимает одну или несколько колонок, которые будут выполнять роль ключа.