Делитель, также известный как фактор или множитель, — это такое целое число m, на которое n делится без остатка. Например, делителями числа 12 являются 1, 2, 3, 4, 6 и 12.

В итоге я написал кое-что с помощью itertools, и в моем коде используется несколько интересных моментов из теории чисел. Я не знаю, буду ли я возвращаться к нему снова, но я надумал написать эту статью, потому что мои попытки решить озвученный выше вопрос перетекли в довольно забавное упражнение.

Простейший подход

Если мы хотим найти все числа, которые делят n без остатка, мы можем просто перебрать числа от 1 до n:

def get_all_divisors_brute(n):

for i in range(1, int(n / 2) + 1):

if n % i == 0:

yield i

yield n

На деле нам нужно дойти только до n/2, потому что все, что больше этого значения, гарантировано не может быть делителем n — если вы разделите n на что-то большее, чем n/2, результат не будет целым числом.

Этот код очень прост, и для малых значений n он работает достаточно хорошо, но он довольно неэффективен и медлителен в других случаях. По мере увеличения n время выполнения линейно увеличивается. Можем ли мы сделать лучше?

Факторизация

В моем проекте я работал в основном с факториалами. Факториал числа n, обозначаемый n! — это произведение всех целых чисел от 1 до n включительно. Например:

8! = 8 × 7 × 6 × 5 × 4 × 3 × 2 × 1

Поскольку факториалы состоят преимущественно из небольших множителей, я решил попробовать получить список делителей, определив сначала наименьшие из них. В частности, я искал простые множители, то есть те, которые также являются простыми числами. (Простое число — это число, единственными делителями которого являются оно само и 1. Например, 2, 3 и 5 являются простыми, а 4 и 6 — нет).

Вот функция, которая находит простые делители числа n:

def get_prime_divisors(n):

i = 2

while i * i <= n:

if n % i == 0:

n /= i

yield i

else:

i += 1

if n > 1:

yield n

Это похоже на предыдущую функцию, использующую перебор делителей: мы продолжаем пробовать множители, и если находим подходящий, то делим на него. В противном случае мы проверяем следующее число. Это довольно стандартный подход к поиску простых множителей.

Теперь мы можем использовать этот метод для получения факторизации числа, то есть для его записи в виде произведения простых чисел. Например, факторизация числа 8! выглядит следующим образом:

8! = 2^7 × 3^2 × 5 × 7

Вычисление такой факторизации относительно эффективно, особенно для факториалов, так как, поскольку все простые множители очень малы, вам не нужно делать много делений.

В теории чисел есть утверждение, называемое основной теоремой арифметики, которое гласит, что простые факторизации (разложения) уникальны: для любого числа n существует только один способ представить его в виде произведения простых множителей. (Я не буду приводить здесь доказательство, но вы можете найти его в Википедии).

Это дает нам способ находить делители путем перебора всех комбинаций простых множителей. Простые множители любого m делителя числа n должны входить в подмножество простых множителей n, иначе m не делило бы число n.

Переход от факторизации к делителям

Для начала разложим исходное число на простые множители с указанием «кратности», то есть мы должны получить список всех множителей и количество раз, которое каждый из них встречается в факторизации:

import collections

def get_all_divisors(n):

primes = get_prime_divisors(n)

primes_counted = collections.Counter(primes)

...

Затем, давайте продолжим и возведем каждое простое число во все степени, которые могут появиться в возможном делителе n.

def get_all_divisors(n):

...

divisors_exponentiated = [

[div ** i for i in range(count + 1)]

for div, count in primes_counted.items()

]

Например, для 8! представленный код выдаст нам следующее:

[

[1, 2, 4, 8, 16, 32, 64, 128], // 2^0, 2^1, ..., 2^7

[1, 3, 9], // 3^0, 3^1, 3^2

[1, 5],

[1, 7],

]

Затем, чтобы получить делители, мы можем использовать довольно удобную функцию itertools.product, которая принимает на вход итерабельные объекты и возвращает все возможные упорядоченные комбинации их элементов. В нашем случае она выбирает по одному числу из каждого списка с возведениями в степень, а затем, перемножая их вместе, мы получаем очередной делитель n.

import itertools

def calc_product(iterable):

acc = 1

for i in iterable:

acc *= i

return acc

def get_all_divisors(n):

...

for prime_exp_combination in itertools.product(*divisors_exponentiated):

yield calc_product(prime_exp_combination)

Таким образом, мы находим все делители n (хотя, в отличие от предыдущих функций, они не отсортированы).

Собираем все вместе

Сложив все это, мы получим следующую функцию для вычисления делителей n:

import collections

import itertools

def get_prime_divisors(n):

i = 2

while i * i <= n:

if n % i == 0:

n /= i

yield i

else:

i += 1

if n > 1:

yield n

def calc_product(iterable):

acc = 1

for i in iterable:

acc *= i

return acc

def get_all_divisors(n):

primes = get_prime_divisors(n)

primes_counted = collections.Counter(primes)

divisors_exponentiated = [

[div ** i for i in range(count + 1)]

for div, count in primes_counted.items()

]

for prime_exp_combination in itertools.product(*divisors_exponentiated):

yield calc_product(prime_exp_combination)

print(list(get_all_divisors(40320))) # 8!

Такая реализация очень эффективна, особенно когда у вас много маленьких простых множителей, как в случае с факториалами, с которыми я работал. Я не знаю, насколько хорошо она покажет себя в общем случае, и, если вы занимаетесь серьезными научными вычислениями, я уверен, что вы легко найдете уже реализованные и оптимизированные алгоритмы для такого рода вещей.

]]>Синтаксис:

lambda [аргументы] : выражение

Лямбда-функция может иметь ноль или более аргументов перед символом ‘:’. При вызове такой функции выполняется выражение, указанное после ‘:’.

Пример определения лямбда-функции:

get_cube = lambda x : x ** 3

Приведенная выше лямбда-функция начинается с ключевого слова lambda, за которым следует параметр x. Выражение x ** 3 после ‘:’ возвращает вызывающему коду значение куба переданного числа. Сама лямбда-функция lambda x : x ** 3 присваивается переменной get_cube для ее последующего вызова как именованной функции. Имя переменной становится именем функции, чтобы мы могли работать с ней как с обычной функцией.

Пример вызова лямбда-функции:

>>> get_cube(4)

64

Приведенное выше определение лямбда-функции аналогично следующей стандартной функции:

def get_cube(x):

return x ** 3

Выражение не обязательно должно всегда возвращать значение. Следующая лямбда-функция не возвращает ничего.

Пример лямбда-функции, не возвращающей значение:

>>> welcome = lambda user: print('Welcome, ' + name + '!')

>>> welcome('Anon')

Welcome, Anon!

Примечание:

Лямбда-функция может иметь только одно выражение. Очевидно, что она не может заменить функцию, тело которой содержит условия, циклы и т.д.

Следующая лямбда-функция содержит несколько параметров.

Пример лямбда-функции с тремя параметрами:

>>> get_prod = lambda a, b, c : a * b * c

>>> get_prod(3, 5, 7)

105

Также лямбда-функция может принимать любое количество параметров.

Пример лямбда-функции с неопределенным числом аргументов (используются только первые 3):

Лямбда-функция без параметров

Ниже приведен пример лямбда-функции без параметров.

>>> welcome = lambda : print('Welcome!')

>>> welcome()

Welcome!

Анонимная функция

Мы можем объявить лямбда-функцию и вызвать ее как анонимную функцию, не присваивая ее переменной.

Пример анонимной лямбда-функции:

>>> (lambda x: x**3)(10)

1000

Здесь lambda x: x3 определяет анонимную функцию и вызывает ее один раз, передавая аргументы в скобках (lambda x: x3)(10).

В Python функции, как и литералы, можно передавать в качестве аргументов.

Лямбда-функции особенно полезны, когда мы хотим отправить функцию на вход другой функции. Мы можем передать анонимную лямбда-функцию, не присваивая ее переменной, в качестве аргумента другой функции.

Пример передачи лямбда-функции в качестве параметра:

def run_task(task):

print('Before running the task')

task()

print('After running the task')

run_task(lambda : print('Task is complete!')) # передача анонимной функции

important_task = lambda : print('Important task is complete!')

run_task(important_task) # передача лямбда-функции

Вывод:

Before running the task

Task is complete!

After running the task

Before running the task

Important task is complete!

After running the task

Представленная выше функция run_task() определена с параметром task, который вызывается как функция внутри run_task(). run_task(lambda : print(‘Task is complete!’)) вызывает функцию run_task() с анонимной лямбда-функцией в качестве аргумента.

В Python есть встроенные функции, которые принимают в качестве аргументов другие функции. Функции map(), filter() и reduce() являются важными инструментами функционального программирования. Все они принимают на вход функцию. Такая функция-аргумент может быть обычной функцией или лямбда-функцией.

Пример передачи лямбда-функции в map():

>>> prime_cube_list = map(lambda x: x**3, [2, 3, 5, 7, 11]) # передача анонимной функции

>>> next(prime_cube_list)

8

>>> next(prime_cube_list)

27

>>> next(prime_cube_list)

125

>>> next(prime_cube_list)

343

>>> next(prime_cube_list)

1331

Давайте посмотрим на следующий фрагмент:

# Простая программа на Python для демонстрации

# работы yield

# Функция-генератор, которая выдает 2 при

# первом обращении, 4 — при втором и

# 8 — при третьем

def simple_generator():

yield 2

yield 4

yield 8

# Код для проверки simple_generator()

for value in simple_generator():

print(value)

Вывод:

2

4

8

Функция с return отправляет указанное значение обратно вызвавшему его коду, в то время как yield может создавать последовательность возвращаемых значений. Мы должны использовать yield, когда хотим обработать множество объектов, но не хотим хранить их все в памяти.

Yield применяется в генераторах Python. Такой генератор определяется как обычная функция, но всякий раз, когда ей нужно выдать значение, она делает это с помощью ключевого слова yield, а не return. Если тело def содержит yield, то функция автоматически становится генератором.

# Программа на Python для генерации степеней 2

# от 2 до 256

def get_next_num():

n = 2

# Бесконечный цикл для генерации степеней 2

while True:

yield n

n *= 2 # При последующем обращении к

# get_next_num() выполнение

# продолжится отсюда

# Код для проверки get_next_num()

for num in get_next_num():

if num > 256:

break

print(num)

Вывод:

2

4

8

16

32

64

128

256

Кубический корень обозначается символом «3√». В случае с квадратным корнем мы использовали только символ ‘√’ без указания степени, который также называется радикалом.

Например, кубический корень из 125, обозначаемый как 3√125, равен 5, так как при умножении 5 на само себя три раза получается 5 x 5 x 5 = 125 = 5^3.

Кубический корень в Python

Чтобы вычислить кубический корень в Python, используйте простое математическое выражение x ** (1. / 3.), результатом которого является кубический корень из x в виде значения с плавающей точкой. Для проверки, корректно ли произведена операция извлечения корня, округлите полученный результат до ближайшего целого числа и возведите его в третью степень, после сравните, равен ли результат x.

x = 8

cube_root = x ** (1./3.)

print(cube_root)

Вывод

2.0

В Python для того, чтобы возвести число в степень, мы используем оператор **. Указание степени, равной 1/3, в выражении с ** позволяет получить кубический корень данного числа.

Извлечение кубического корня из отрицательного числа в Python

Мы не можем найти кубический корень из отрицательных чисел указанным выше способом. Например, кубический корень из целого числа -64 должен быть равен -4, но Python возвращает 2+3.464101615137754j.

Чтобы найти кубический корень из отрицательного числа в Python, сначала нужно применить функцию abs(), а затем можно воспользоваться представленным ранее простым выражением с ** для его вычисления.

Давайте напишем полноценную функцию, которая будет проверять, является ли входное число отрицательным, а затем вычислять его кубический корень соответствующим образом.

def get_cube_root(x):

if x < 0:

x = abs(x)

cube_root = x**(1/3)*(-1)

else:

cube_root = x**(1/3)

return cube_root

print(round(get_cube_root(64)))

print(get_cube_root(-64))

Вывод

4

-3.9999999999999996

Как видите, нам нужно округлить результат, чтобы получить целочисленное значение кубического корня.

Использование функции Numpy cbrt()

Библиотека numpy предлагает еще один вариант нахождения кубического корня в Python, который заключается в использовании метода cbrt(). Функция np.cbrt() вычисляет кубический корень для каждого элемента переданного ей массива.

import numpy as np

cubes = [125, -64, 27, -8, 1]

cube_roots = np.cbrt(cubes)

print(cube_roots)

Вывод

[ 5. -4. 3. -2. 1.]

Функция np.cbrt() — самый простой способ получения кубического корня числа. Она не испытывает проблем с отрицательными входными данными и возвращает целочисленное число, например, -4 для переданного в качестве аргумента числа -64, в отличие от вышеописанных подходов.

]]>В этой статье мы рассмотрим несколько примеров использования циклов for с функцией range() в Python.

Циклы for в Python

Циклы for повторяют определённый код для некоторого набора значений.

Из документации Python можно узнать, что в нем циклы for работают несколько иначе, чем в таких языках, как JavaScript или C.

Цикл for присваивает итерируемой переменной каждое значение из предоставленного списка, массива или строки и повторяет код в теле цикла for для каждого установленного таким образом значения переменной-итератора.

В приведенном ниже примере мы используем цикл for для вывода каждого числа в нашем массиве.

# Простой пример цикла for

for i in [0, 1, 2, 3, 4, 5]:

print(i, end="; ") # выведет: 0; 1; 2; 3; 4; 5;

В тело цикла for можно включить и более сложную логику. В следующем примере мы выводим результат небольшого вычисления, основанного на значении переменной i.

# Пример посложнее

for i in [0, 1, 2, 3, 4, 5]:

x = (i-2)*(i+2) - i**2 + 4

print(x, end="; ") # выведет: 0; 0; 0; 0; 0; 0;

Когда значения в массиве для нашего цикла for представляют собой некоторую закономерную последовательность, мы можем использовать функцию Python range() вместо того, чтобы вписывать содержимое нашего массива вручную.

Функция Range в Python

Функция range() возвращает последовательность целых чисел на основе переданных ей аргументов. Дополнительную информацию можно найти в документации Python по функции range().

range(stop)

range(start, stop[, step])

Аргумент start — это первое значение в диапазоне. Если функция range() вызывается только с одним аргументом, то Python считает, что start = 0.

Аргумент stop — это верхняя граница диапазона. Важно понимать, что само граничное значение не включается в последовательность.

В примере ниже у нас есть диапазон, начинающийся со значения по умолчанию, равному 0, и включающий целые числа меньше 6.

# Использование range() с единственным аргументом

for i in range(6):

print(i, end="; ") # выведет: 0; 1; 2; 3; 4; 5;

В следующем примере мы задаем start = -2 и включаем целые числа меньше 4.

# В этот раз передаются два аргумента

for i in range(-2, 4):

print(i, end="; ") # выведет: -2; -1; 0; 1; 2; 3;

Необязательное значение step (шаг) управляет приращением между значениями последовательности. По умолчанию step = 1.

В нашем последнем примере мы используем диапазон целых чисел от -2 до 6 и задаем step = 2.

# Здесь используются все аргументы range()

for i in range(-2, 6, 2):

print(i, end="; ") # выведет: -2; 0; 2; 4;

Заключение

В этой статье мы рассмотрели циклы for в Python и функцию range().

Циклы for обеспечивают повторное выполнение блока кода для всех значений в указанном списке, массиве, строке или последовательности, определенной с помощью функции range().

Как было показано, мы можем использовать range(), чтобы упростить написание цикла for. При вызове данной функции вы обязаны указать stop значение, также вами могут быть определены начальное значение и шаг между целыми числами в возвращаемом диапазоне.

]]>В повседневной практике необходимость изменить одно или несколько значений в списке возникает довольно часто. Предположим, вы создаете меню для ресторана и замечаете, что неправильно определили один из пунктов. Чтобы исправить подобную ошибку, вам нужно просто заменить существующий элемент в списке.

Замена элемента в списке на Python

Вы можете заменить элемент в списке на Python, используя цикл for, обращение по индексу или list comprehension. Первые два метода изменяют существующий список, а последний создает новый с заданными изменениями.

Давайте кратко опишем каждый метод:

- Обращение по индексу: мы используем порядковый номер элемента списка для изменения его значения. Знак равенства используется для присвоения нового значения выбранному элементу.

- List comprehension или генератор списка создает новый список из существующего. Синтаксис list comprehension позволяет добавлять различные условия для определения значений в новом списке.

- Цикл For выполняет итерацию по элементам списка. Для внесения изменений в данном случае используется обращение по индексу. Мы применяем метод enumerate() для создания двух списков: с индексами и с соответствующими значениями элементов — и итерируем по ним.

В этом руководстве мы рассмотрим каждый из этих методов. Для более полного понимания приведенных подходов мы также подготовили примеры использования каждого из них.

Замена элемента в списке на Python: обращение по индексу

Самый простой способ заменить элемент в списке — это использовать синтаксис обращения к элементам по индексу. Такой способ позволяет выбрать один элемент или диапазон последовательных элементов, а с помощью оператора присваивания вы можете изменить значение в заданной позиции списка.

Представим, что мы создаем программу, которая хранит информацию о ценах в магазине одежды. Цена первого товара в нашем списке должна быть увеличена на $2.

Начнем с создания списка, который содержит цены на наши товары:

prices = [29.30, 10.20, 44.00, 5.99, 81.90]

Мы используем обращение по индексу для выбора и изменения первого элемента в нашем списке 29.30. Данное значение имеет нулевой индекс. Это связано с тем, что списки индексируются, начиная с нуля.

prices[0] = 31.30

print(prices)

Наш код выбирает элемент в нулевой позиции и устанавливает его значение равным 31.30, что на $2 больше прежней цены. Далее мы возвращаем список со скорректированной ценой первого товара:

[31.30, 10.20, 44.00, 5.99, 81.90]

Мы также можем изменить наш список, добавив два к текущему значению prices[0]:

prices[0] = prices[0] + 2

print(prices)

prices[0] соответствует первому элементу в нашем списке (тот, который находится в позиции с нулевым индексом).

Этот код выводит список с теми же значениями, что и в первом случае:

[31.30, 10.20, 44.00, 5.99, 81.90]

Замена элемента в списке на Python: list comprehension

Применение генератора списка в Python может быть наиболее изящным способом поиска и замены элемента в списке. Этот метод особенно полезен, если вы хотите создать новый список на основе значений существующего.

Использование list comprehension позволяет перебирать элементы существующего списка и образовывать из них новый список на основе определенного критерия. Например, из последовательности слов можно скомпоновать новую, выбрав только те, которые начинаются на «C».

Здесь мы написали программу, которая рассчитывает 30% скидку на все товары в магазине одежды, стоимость которых превышает $40. Мы используем представленный ранее список цен на товары:

prices = [29.30, 10.20, 44.00, 5.99, 81.90]

Далее мы применяем list comprehension для замены элементов в нашем списке:

sale_prices = [round(price - (price * 30 / 100), 2) if price > 40 else price for price in prices]

print(sale_prices)

Таким образом, наш генератор проходит по списку «prices» и ищет значения стоимостью более 40 долларов. К найденным товарам применяется скидка в 30%. Мы округляем полученные значения цен со скидкой до двух десятичных знаков после точки с помощью метода round().

Наш код выводит следующий список с новыми ценами:

[29.3, 10.2, 30.8, 5.99, 57.33]

Замена элемента в списке на Python: цикл for

Вы можете изменить элементы списка с помощью цикла for. Для этого нам понадобится функция Python enumerate(). Эта функция возвращает два списка: список с номерами индексов и список со значениями соответствующих элементов. Мы можем выполнить необходимые итерации по этим двум последовательностям с помощью единственного цикла for.

В этом примере мы будем использовать тот же список цен:

prices = [29.30, 10.20, 44.00, 5.99, 81.90]

Затем мы определим цикл for, который проходит по данному списку с помощью функции enumerate():

for index, item in enumerate(prices):

if item > 40:

prices[index] = round(prices[index] - (prices[index] * 30 / 100), 2)

print(prices)

В коде выше переменная «index» содержит позиционный номер элемента. В свою очередь «item» — это значение, хранящееся в элементе списка на данной позиции. Индекс и соответствующее значение, возвращаемые методом enumerate(), разделяются запятой.

Подобное получение двух или более значений из возвращаемого функцией кортежа называется распаковкой. Мы «распаковали» элементы двух списков из метода enumerate().

Здесь мы используем ту же формулу, что и ранее, для расчета 30% скидки на товары стоимостью более 40 долларов. Давайте запустим наш код и посмотрим, что получится:

[29.3, 10.2, 30.8, 5.99, 57.33]

Наш код успешно изменяет товары в списке «prices» в соответствии с нашей скидкой.

Заключение

Вы можете заменить элементы в списке на Python с помощью обращения по индексу, list comprehension или цикла for.

Если вы хотите изменить одно значение в списке, то наиболее подходящим будет обращение по индексу. Для замены нескольких элементов в списке, удовлетворяющих определенному условию, хорошим решением будет использование list comprehension. Хотя циклы for более функциональны, они менее элегантны, чем генераторы списков.

]]>Определение функции

Функция — это многократно используемый блок программных инструкции, предназначенный для выполнения определенной задачи. Для определения функции в Python используется ключевое слово def. Ниже приведен синтаксис определения функции.

Синтаксис:

def имя_функции(параметры):

"""docstring"""

инструкция1

инструкция2

...

...

return [выражение]

За ключевым словом def следует подходящий идентификатор (имя функции) и круглые скобки. В круглых скобках может быть дополнительно указан один или несколько параметров. Символ ‘:’ после круглых скобок начинает блок с отступом (тело функции).

Первой инструкцией в теле функции может быть строка, которая называется docstring. Она описывает функциональность функции/класса. Строка docstring не является обязательной.

В общем случае тело функции содержит одну или несколько инструкций, которые выполняют некоторые действия. В нем также может использоваться ключевое слово pass.

Последней командой в блоке функции зачастую является инструкция return. Она возвращает управление обратно вызвавшему функцию окружению. Если после оператора return стоит выражение, то его значение также передается в вызывающий код.

В следующем примере определена функция welcome().

Пример созданной пользователем функции:

def welcome():

"""This function prints 'Welcome!'"""

print('Welcome!')

Выше мы определили функцию welcome(). Первая инструкция — это docstring, в котором сообщается о том, что делает эта функция. Вторая — это метод print, который выводит указанную строку на консоль. Обратите внимание, что welcome() не содержит оператор return.

Чтобы вызвать определенную ранее функцию, просто используйте выражение, состоящее из ее имени и двух круглых скобок ‘()’, в любом месте кода. Например, приведенная выше функция может быть вызвана так: welcome().

Пример вызова определенной пользователем функции:

welcome()

Вывод:

Welcome!

По умолчанию все функции возвращают None, если отсутствует оператор return.

returned_value = welcome()

print(returned_value)

Вывод:

Welcome!

None

Функция help() выводит docstring, как показано ниже.

>>> help(welcome)

Help on function welcome in module __main__:

welcome()

This function prints 'Welcome!'

Параметры функции

Функции также могут принимать на вход один или несколько параметров (они же аргументы) и использовать их для вычислений, определенных внутри функционального блока. В таком случае параметрам/аргументам даются подходящие формальные имена. Для примера изменим функцию welcome(): теперь она принимает в качестве параметра строку user_name; также изменена инструкция с функцией print() для отображения более персонализированного приветствия.

Пример функции с аргументами:

def welcome(user_name):

print('Welcome, ' + user_name + '!')

welcome('Anon') # вызов функции с параметром

Вывод:

Welcome, Anon!

Именованные аргументы, используемые в определении функции, называются формальными параметрами. В свою очередь, объекты, передаваемые в функцию при ее вызове, называются фактическими аргументами/параметрами.

Параметры функции могут иметь аннотацию для указания типа аргумента с использованием синтаксиса parameter:type. Например, следующая аннотация указывает тип параметра string.

Пример использования аннотации типов:

def welcome(user_name:str):

print('Welcome, ' + user_name + '!')

welcome('Anon') # передача строки в функцию

# пройдет нормально

welcome(42) # а передача числа в функцию

# вызовет ошибку

Передача нескольких параметров

Функция может иметь множество параметров. Представленная ниже вариация welcome() принимает три аргумента.

Пример определения функции с несколькими параметрами:

def welcome(first_name:str, last_name:str):

print('Welcome, ' + first_name + ' ' + last_name + '!')

welcome('Anton', 'Chekhov') # передача аргументов в функцию

Вывод:

Welcome, Anton Chekhov!

Неизвестное количество аргументов

Функция в Python может иметь неизвестное заранее число параметров. Укажите * перед аргументом, если вы не знаете, какое количество параметров передаст пользователь.

Пример функции с неизвестным числом параметров (используются только первые 3):

def welcome(*name_parts):

message = 'Welcome, ' + name_parts[0] + " "

message += name_parts[1] + " " + name_parts[2]

print(message + "!")

welcome('Anton', 'Pavlovich', 'Chekhov')

Вывод:

Welcome, Anton Pavlovich Chekhov!

Следующая функция работает с любым количеством аргументов.

Пример функции, использующей все переданные ей параметры:

def welcome(*name_parts):

message = 'Welcome,'

for part in name_parts:

message += " " + part

print(message + "!")

welcome('Anton', 'Pavlovich', 'Chekhov',

'and', 'Fyodor', 'Mikhailovich', 'Dostoevsky')

Вывод:

Welcome, Anton Pavlovich Chekhov and Fyodor Mikhailovich Dostoevsky!

Аргументы-ключевые слова

Чтобы использовать функцию с параметрами, необходимо предоставить ей фактические аргументы в количестве, соответствующем числу формальных. С другой стороны, при вызове функции мы не обязаны соблюдать указанный в определении порядок параметров. Но в таком случае при передаче значений аргументов мы должны явно указать имена соответствующих формальных параметров. В следующем примере фактические значения передаются с использованием имен параметров.

def welcome(first_name:str, last_name:str):

print('Welcome, ' + first_name + ' ' + last_name + '!')

welcome(last_name='Chekhov', first_name='Anton') # передача

# аргументов в функцию в произвольном порядке

Вывод:

Welcome, Anton Chekhov!

Аргументы-ключевые слова **kwarg

Функция может иметь только один параметр с префиксом **. Он инициализирует новое упорядоченное отображение (словарь), содержащее все оставшееся без соответствующего формального параметра аргументы-ключевые слова.

Пример использования **kwarg:

def welcome(**name_parts):

print('Welcome, ' + name_parts['first_name'] + ' ' + name_parts['last_name'] + '!')

welcome(last_name='Chekhov', first_name='Anton')

welcome(last_name='Chekhov', first_name='Anton', age='28')

welcome(last_name='Chekhov') # вызовет KeyError

Вывод:

Welcome, Anton Chekhov!

Welcome, Anton Chekhov!

При использовании параметра ** порядок аргументов не имеет значения. Однако их имена должны быть идентичными. Доступ к аргументам-ключевым словам для получения переданных значений осуществляется с помощью такого выражения: имя_параметра_kwarg[‘имя_переданного_аргумента’].

Если функция обращается к аргументу-ключевому слову, но вызывающий код не передает этот параметр, то она вызовет исключение KeyError, как показано ниже.

Пример функции, вызывающей KeyError:

def welcome(**name_parts):

print('Welcome, ' + name_parts['first_name'] + ' ' + name_parts['last_name'] + '!')

welcome(last_name='Chekhov') # вызывет KeyError: необходимо предоставить аргумент 'first_name'

Вывод:

Traceback (most recent call last):

...

line 2, in welcome

print('Welcome, ' + name_parts['first_name'] + ' ' + name_parts['last_name'] + '!')

KeyError: 'first_name'

Параметры со значением по умолчанию

При определении функции ее параметрам могут быть присвоены значения по умолчанию. Такое значение заменяется на соответствующий фактический аргумент, если он был передан при вызове функции. Однако если фактический параметр не был предоставлен, то внутри функции будет использоваться значение по умолчанию.

Представленная ниже функция welcome() определена с параметром name, имеющим значение по умолчанию ‘Anon’. Оно будет заменено только в том случае, если вызывающей стороной будет передан какой-либо фактический аргумент.

Пример функции со значением по умолчанию:

def welcome(user:str = 'Anon'):

print('Welcome, ' + user + '!')

welcome()

welcome('Chekhov')

Вывод:

Welcome, Anon!

Welcome, Chekhov!

Функция с возвращаемым значением

Чаще всего нам нужен результат работы функции для использования в дальнейших вычислениях. Следовательно, когда функция завершает выполнение, она также должна возвращать какое-то результирующее значение.

Для того, чтобы передать подобное значение внешнему коду, функция должна содержать инструкцию с оператором return. В этом случае возвращаемое значение должно быть указано после return.

Пример функции с возвращаемым значением:

def get_product(a, b):

return a * b

Ниже показано, как при вызове функции get_product() получить результат ее работы.

Пример использования функции с возвращаемым значением:

result = get_product(6, 7)

print(result)

result = get_product(3, get_product(4, 5))

print(result)

Вывод:

42

60

Enum в Python

Перечисления — это наборы символических имен, связанных с уникальными константными значениями. Они используются для создания простых пользовательских типов данных, таких как времена года, недели, виды оружия в игре, планеты, оценки или дни. По соглашению имена перечислений начинаются с заглавной буквы и употребляются в единственном числе.

Модуль enum используется для создания перечислений в Python. Вы можете определить их с помощью ключевого слова class или с помощью функционального API.

Существуют специальные производные перечисления enum.IntEnum, enum.IntFlag и enum.Flag.

Простой пример использования enum в Python

Ниже приведен простой пример кода на Python, использующего перечисления.

#!/usr/bin/python3

from enum import Enum

class Weapon(Enum):

SWORD = 1

BOW = 2

DAGGER = 3

CLUB = 4

ranged_weapon = Weapon.BOW

print(ranged_weapon)

if ranged_weapon == Weapon.BOW:

print("It's a bow")

print(list(Weapon))

В примере у нас есть перечисление Weapon, которое имеет четыре различных значения: SWORD, BOW, DAGGER и CLUB. Чтобы получить доступ к одному из членов enum, мы должны указать название перечисления, за которым следует точка и имя интересующей нас символической константы.

class Weapon(Enum):

SWORD = 1

BOW = 2

DAGGER = 3

CLUB = 4

Перечисление Weapon создается нами с помощью ключевого слова class, то есть происходит наследование от базового класса enum.Enum. После этого мы явно задаем числа, соответствующие значениям перечисления.

ranged_weapon = Weapon.BOW

print(ranged_weapon)

Здесь символическая константа присваивается переменной и выводится на консоль.

if ranged_weapon == Weapon.BOW:

print("It's a bow")

Данный фрагмент демонстрирует использование Weapon.BOW в выражении if.

print(list(Weapon))

С помощью встроенной функции list мы получаем список всех возможных значений для перечисления Weapon.

Вывод:

Weapon.BOW

It's a bow

[, , , ]

Еще один пример использования enum в Python

В следующем примере представлена другая часть базовой функциональности перечислений в Python.

#!/usr/bin/python3

from enum import Enum

class Weapon(Enum):

SWORD = 1

BOW = 2

DAGGER = 3

CLUB = 4

weapon = Weapon.SWORD

print(weapon)

print(isinstance(weapon, Weapon))

print(type(weapon))

print(repr(weapon))

print(Weapon['SWORD'])

print(Weapon(1))

И снова мы имеем дело с enum Weapon, созданным с помощью класса.

print(weapon)

Здесь мы выводим человекочитаемое строковое представление одного из членов перечисления.

print(isinstance(weapon, Weapon))

С помощью метода isinstance мы проверяем, имеет ли переменная значение типа Weapon.

print(type(weapon))

Функция type выводит тип переменной.

print(repr(weapon))

Функция repr предоставляет дополнительную информацию о перечислении.

print(Weapon['SWORD'])

print(Weapon(1))

Доступ к символической константе можно получить как по ее имени, так и по значению (индексу).

Вывод:

Weapon.SWORD

True

Weapon.SWORD

Weapon.SWORD

Функциональное создание enum в Python

Перечисления Python также могут быть созданы с помощью функционального API.

from enum import Enum

Weapon = Enum('Weapon', 'SWORD BOW DAGGER CLUB', start=1)

weapon = Weapon.DAGGER

print(weapon)

if weapon == Weapon.DAGGER:

print("Dagger")

Есть несколько способов, как мы можем указать значения, используя функциональный API. В последующих примерах мы будем применять различные варианты их задания.

Weapon = Enum('Weapon', 'SWORD BOW DAGGER CLUB', start=1)

Здесь наименования символических констант задаются в строке, разделенные пробелами. Число, переданное в start, определяет начало нумерации значений для членов перечисления.

Вывод:

Weapon.DAGGER

Dagger

Итерирование enum в Python

Мы можем выполнять итерацию по перечислениям Python.

from enum import Enum

Weapon = Enum('Weapon', 'SWORD BOW DAGGER CLUB', start=10)

for weapon in Weapon:

print(weapon)

for weapon in Weapon:

print(weapon.name, weapon.value)

В этом примере мы создаем перечисление Weapon, где символьные константы задаются в виде списка строк.

for weapon in Weapon:

print(weapon)

В коде выше мы выполняем итерации по членам перечисления в цикле for.

for weapon in Weapon:

print(weapon.name, weapon.value)

Здесь мы выводим их имена и значения.

Вывод:

Weapon.SWORD

Weapon.BOW

Weapon.DAGGER

Weapon.CLUB

SWORD 10

BOW 11

DAGGER 12

CLUB 13

Автоматическое назначение имен для enum в Python

Значения символьных констант могут быть автоматически установлены с помощью функции auto().

#!/usr/bin/python3

from enum import Enum, auto

class Weapon(Enum):

SWORD = auto()

BOW = auto()

DAGGER = auto()

CLUB = auto()

for weapon in Weapon:

print(weapon.value)

В этом фрагменте мы создали перечисление Weapon, члены которого получают значения с помощью функции auto.

Вывод:

1

2

3

4

Уникальные значения enum в Python

Значения символьных констант могут быть принудительно уникальными с помощью декоратора @unique.

#!/usr/bin/python3

from enum import Enum, unique

@unique

class Weapon(Enum):

SWORD = 1

BOW = 2

DAGGER = 3

CLUB = 3

# CLUB = 4

for weapon in Weapon:

print(weapon)

Данный пример завершается с ошибкой ValueError: duplicate values found in : CLUB -> DAGGER, потому что члены CLUB и DAGGER имеют одинаковые значения. Если мы закомментируем декоратор @unique, пример выведет три члена; CLUB игнорируется.

Python enum __members__

Специальный атрибут members представляет собой упорядоченное отображение имен на символьные константы enum, доступное только для чтения.

#!/usr/bin/python3

from enum import Enum

Weapon = Enum('Weapon', [('SWORD', 1), ('BOW', 2),

('DAGGER', 3), ('CLUB', 4)])

for name, member in Weapon.__members__.items():

print(name, member)

В этом примере мы используем свойство members. Члены перечисления заданы списком кортежей с помощью функционального API.

Вывод:

SWORD Weapon.SWORD

BOW Weapon.BOW

DAGGER Weapon.DAGGER

CLUB Weapon.CLUB

enum.Flag

Enum.Flag — это базовый класс для создания пронумерованных констант, которые можно объединять с помощью побитовых операций без потери их принадлежности к Flag.

#!/usr/bin/python3

from enum import Flag, auto

class Permission(Flag):

READ = auto()

WRITE = auto()

EXECUTE = auto()

print(list(Permission))

print(Permission.READ | Permission.WRITE)

Пример выше показывает, как флаг может быть использован для проверки или установки разрешений.

Вывод:

[<Permission.READ: 1>, <Permission.WRITE: 2>, <Permission.EXECUTE: 4>]

Permission.WRITE|READЕсли вы считаете Colorama полезной, не забудьте поблагодарить ее авторов и сделать пожертвование. Спасибо!

Установка

pip install colorama

# или

conda install -c anaconda colorama

Описание

Управляющие символы ANSI давно используются для создания цветного текста и позиционирования курсора в терминале на Unix и Mac. Colorama делает возможным их использование на платформе Windows, оборачивая stdout, удаляя найденные ANSI-последовательности (которые будут выглядеть как тарабарщина при выводе) и преобразуя их в соответствующие вызовы win32 для изменения состояния командной строки. На других платформах Colorama ничего не меняет.

В результате мы получаем простой кроссплатформенный API для отображения цветного терминального текста из Python, а также следующий приятный побочный эффект: существующие приложения или библиотеки, использующие ANSI-последовательности для создания цветного вывода на Linux или Mac, теперь могут работать и на Windows, просто вызвав colorama.init().

Альтернативный подход заключается в установке ansi.sys на машины с Windows, что обеспечивает одинаковое поведение для всех приложений, работающих с командной строкой. Colorama предназначена для ситуаций, когда это не так просто (например, может быть, у вашего приложения нет программы установки).

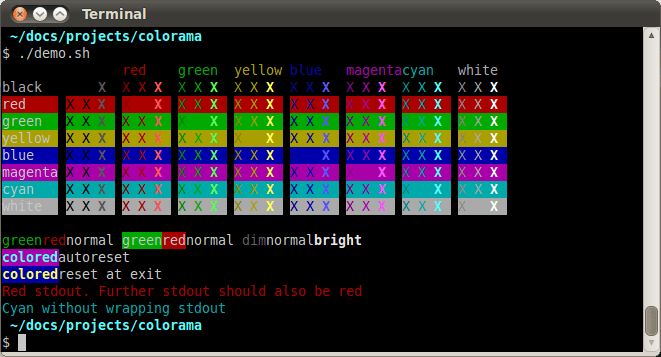

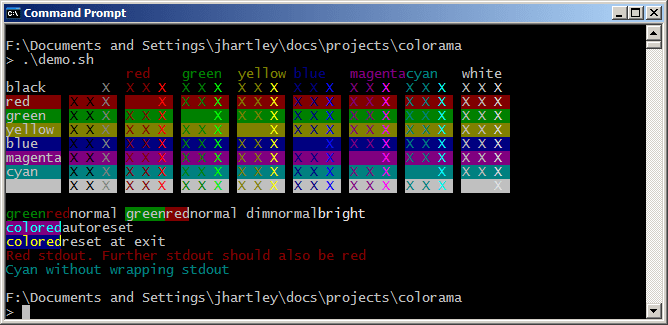

Демо-скрипты в репозитории исходного кода библиотеки выводят небольшой цветной текст, используя последовательности ANSI. Сравните их работу в Gnome-terminal и в Windows Command-Prompt, где отображение осуществляется с помощью Colorama:

Эти скриншоты показывают, что в Windows Colorama не поддерживает ANSI ‘dim text’ (тусклый текст); он выглядит так же, как и ‘normal text’.

Использование

Инициализация

Приложения должны инициализировать Colorama с помощью:

from colorama import init

init()

В Windows вызов init() отфильтрует управляющие ANSI-последовательности из любого текста, отправленного в stdout или stderr, и заменит их на эквивалентные вызовы Win32.

На других платформах вызов init() не имеет никакого эффекта (если только вы не укажете другие дополнительные возможности; см. раздел «Аргументы Init», ниже). По задумке разработчиков такое поведение позволяет приложениям вызывать init() безоговорочно на всех платформах, после чего вывод ANSI должен просто работать.

Чтобы прекратить использование Colorama до выхода из программы, просто вызовите deinit(). Данный метод вернет stdout и stderr к их исходным значениям, так что Colorama будет отключена. Чтобы возобновить ее работу, используйте reinit(); это выгоднее, чем повторный вызов init() (но делает то же самое).

Цветной вывод

Кроссплатформенное отображение цветного текста может быть упрощено за счет использования константных обозначений для управляющих последовательностей ANSI, предоставляемых библиотекой Colorama:

from colorama import init

init()

from colorama import Fore, Back, Style

print(Fore.GREEN + 'зеленый текст')

print(Back.YELLOW + 'на желтом фоне')

print(Style.BRIGHT + 'стал ярче' + Style.RESET_ALL)

print('обычный текст')

При этом вы также можете использовать ANSI-последовательности напрямую в своем коде:

print('\033[31m' + 'красный текст')

print('\033[39m') # сброс к цвету по умолчанию

Еще одним вариантом является применение Colorama в сочетании с существующими ANSI библиотеками, такими как Termcolor или Blessings. Такой подход настоятельно рекомендуется для чего-то большего, чем тривиальное выделение текста:

from colorama import init

from termcolor import colored

# используйте Colorama, чтобы Termcolor работал и в Windows

init()

# теперь вы можете применять Termcolor для вывода

# вашего цветного текста

print(colored('Termcolor and Colorama!', 'red', 'on_yellow'))

Доступны следующие константы форматирования:

// цвет текста

Fore: BLACK, RED, GREEN, YELLOW, BLUE, MAGENTA, CYAN, WHITE, RESET.

// цвет фона

Back: BLACK, RED, GREEN, YELLOW, BLUE, MAGENTA, CYAN, WHITE, RESET.

// яркость текста и общий сброс

Style: DIM, NORMAL, BRIGHT, RESET_ALL

Style.RESET_ALL сбрасывает настройки цвета текста, фона и яркости. Colorama выполнит этот сброс автоматически при выходе из программы.

Позиционирование курсора

Библиотекой поддерживаются ANSI-коды для изменения положения курсора. Пример их генерации смотрите в demos/demo06.py.

Аргументы Init

init() принимает некоторые **kwargs для переопределения поведения по умолчанию.

init(autoreset=False):

Если вы постоянно осуществляете сброс указанных вами цветовых настроек после каждого вывода, init(autoreset=True) будет выполнять это по умолчанию:

from colorama import init, Fore

init(autoreset=True)

print(Fore.GREEN + 'зеленый текст')

print('автоматический возврат к обычному')

init(strip=None):

Передайте True или False, чтобы определить, должны ли коды ANSI удаляться при выводе. Поведение по умолчанию — удаление, если программа запущена на Windows или если вывод перенаправляется (не на tty).

init(convert=None):

Передайте True или False, чтобы определить, следует ли преобразовывать ANSI-коды в выводе в вызовы win32. По умолчанию Colorama будет их конвертировать, если вы работаете под Windows и вывод осуществляется на tty (терминал).

init(wrap=True):

В Windows Colorama заменяет sys.stdout и sys.stderr прокси-объектами, которые переопределяют метод .write() для выполнения своей работы. Если эта обертка вызывает у вас проблемы, то ее можно отключить, передав init(wrap=False). Поведение по умолчанию — обертывание, если autoreset, strip или convert равны True.

Когда обертка отключена, цветной вывод на платформах, отличных от Windows, будет продолжать работать как обычно. Для кроссплатформенного цветного отображения текста можно использовать AnsiToWin32 прокси, предоставляемый Colorama, напрямую:

import sys

from colorama import init, Fore, AnsiToWin32

init(wrap=False)

stream = AnsiToWin32(sys.stderr).stream

# Python 2

print >>stream, Fore.RED + 'красный текст отправлен в stderr'

# Python 3

print(Fore.RED + 'красный текст отправлен в stderr', file=stream)

Распознаваемые ANSI-последовательности

Последовательности ANSI обычно имеют вид:

ESC [ <параметр> ; <параметр> ... <команда>

Где <параметр> — целое число, а <команда> — один символ. В <команда> передается ноль или более параметров. Если параметры не представлены, это, как правило, синоним передачи одного нуля. В последовательности нет пробелов; они были добавлены здесь исключительно для удобства чтения.

Единственные ANSI-последовательности, которые Colorama преобразует в вызовы win32, это:

ESC [ 0 m # сбросить все (цвета и яркость)

ESC [ 1 m # яркий

ESC [ 2 m # тусклый (выглядит так же, как обычная яркость)

ESC [ 22 м # нормальная яркость

# FOREGROUND (цвет текста)

ESC [ 30 м # черный

ESC [ 31 м # красный

ESC [ 32 м # зеленый

ESC [ 33 м # желтый

ESC [ 34 m # синий

ESC [ 35 m # пурпурный

ESC [ 36 m # голубой

ESC [ 37 m # белый

ESC [ 39 m # сброс

# ФОН

ESC [ 40 m # черный

ESC [ 41 m # красный

ESC [ 42 м # зеленый

ESC [ 43 m # желтый

ESC [ 44 m # синий

ESC [ 45 m # пурпурный

ESC [ 46 m # голубой

ESC [ 47 m # белый

ESC [ 49 m # сброс

# позиционирование курсора

ESC [ y;x H # позиционирование курсора в позиции x, y (у направлена вниз)

ESC [ y;x f # позиционирование курсора в точке x, y

ESC [ n A # перемещение курсора на n строк вверх

ESC [ n B # перемещение курсора на n строк вниз

ESC [ n C # перемещение курсора на n символов вперед

ESC [ n D # перемещение курсора на n символов назад

# очистить экран

ESC [ режим J # очистить экран

# очистить строку

ESC [ режим K # очистить строку

Несколько числовых параметров команды ‘m’ могут быть объединены в одну последовательность:

ESC [ 36 ; 45 ; 1 m # яркий голубой текст на пурпурном фоне

Все другие ANSI-последовательности вида ESC [ <параметр> ; <параметр> … <команда> молча удаляются из вывода в Windows.

Любые другие формы ANSI-последовательностей, такие как односимвольные коды или альтернативные начальные символы, не распознаются и не удаляются. Однако было бы здорово добавить их. Вы можете сообщить разработчикам, если это будет полезно для вас, через Issues на GitHub.

Текущий статус и известные проблемы

Лично я тестировал библиотеку только на Windows XP (CMD, Console2), Ubuntu (gnome-terminal, xterm) и OS X.

Некоторые предположительно правильные ANSI-последовательности не распознаются (см. подробности ниже), но, насколько мне известно, никто еще не жаловался на это. Загадка.

См. нерешенные проблемы и список пожеланий: https://github.com/tartley/colorama/issues

Если у вас что-то не работает или делает не то, что вы ожидали, авторы библиотеки будут рады услышать об этом в списке проблем, указанном выше, также они с удовольствием ждут и предоставляют доступ к коммиту любому, кто напишет один или, может, пару рабочих патчей.

]]>Код #1: Демонстрация работы yield

# Код на Python3 для демонстрации

# использования ключевого слова yield

# генерация нового списка, состоящего

# только из четных чисел

def get_even(list_of_nums) :

for i in list_of_nums:

if i % 2 == 0:

yield i

# инициализация списка

list_of_nums = [1, 2, 3, 8, 15, 42]

# вывод начального списка

print ("До фильтрации в генераторе: " + str(list_of_nums))

# вывод только четных значений из списка

print ("Только четные числа: ", end = " ")

for i in get_even(list_of_nums):

print (i, end = " ")

Вывод

До фильтрации в генераторе: [1, 2, 3, 8, 15, 42]

Только четные числа: 2 8 42

Код #2

# Данная Python программа выводит

# числа от 1 до 15, возведенные в куб,

# используя yield и, следовательно, генератор

# Функция ниже будет бесконечно генерировать

# последовательность чисел в третьей степени,

# начиная с 1

def nextCube():

acc = 1

# Бесконечный цикл

while True:

yield acc**3

acc += 1 # После повторного обращения

# исполнение продолжится отсюда

# Ниже мы запрашиваем у генератора

# и выводим ровно 15 чисел

count = 1

for num in nextCube():

if count > 15:

break

print(num)

count += 1

Вывод:

1

8

27

64

125

216

343

512

729

1000

1331

1728

2197

2744

3375

Преимущества yield:

- Поскольку генераторы автоматически сохраняют и управляют состояниями своих локальных переменных, программист не должен заботиться о накладных расходах, связанных с выделением и освобождением памяти.

- Так как при очередном вызове генератор возобновляет свою работу, а не начинает с самого начала, общее время выполнения сокращается.

Недостатки yield:

- Иногда использование yield может вызвать ошибки, особенно если вызов функции не обрабатывается должным образом.

- За оптимизацию времени работы и используемой памяти приходится платить сложностью кода, поэтому иногда трудно сходу понять логику, лежащую в его основе.

Практическое применение

Один из вариантов практического применения генераторов заключается в том, что при обработке большого объема данных и поиске в нем, выгодно использовать yield, так как зачастую нам не нужно повторно осматривать уже проверенные объекты. Такой подход значительно сокращает затраченное программой время. В зависимости от конкретной ситуации существует множество различных вариантов использования yield.

# Код Python3 для демонстрации

# использования ключевого слова yield

# Поиск слова pythonru в тексте

# Импорт библиотеки для работы

# с регулярными выражениями

import re

# Этот генератор создает последовательность

# значений True: по одному на каждое

# найденное слово pythonru

# Также для наглядности он выводит

# обработанные слова

def get_pythonru (text) :

text = re.split('[., ]+', text)

for word in text:

print(word)

if word == "pythonru":

yield True

# Инициализация строки, содержащей текст для поиска

text = "В Интернете есть множество сайтов, \

но только один pythonru. \

Программа никогда не прочтет \

последнее предложение."

# Инициализация переменной с результатом

result = "не найден"

# Цикл произведет единственную итерацию

# в случае наличия в тексте pythonru и

# не сделает ни одной, если таких слов нет

for j in get_pythonru(text):

result = "найден"

break

print ('Результат поиска: %s' % result)

Вывод

В

Интернете

есть

множество

сайтов

но

только

один

pythonru

Результат поиска: найден

Сначала давайте вкратце рассмотрим, что такое список в Python и как найти в нем максимальное значение или просто наибольшее число.

Список в Python

В Python есть встроенный тип данных под названием список (list). По своей сути он сильно напоминает массив. Но в отличие от последнего данные внутри списка могут быть любого типа (необязательно одного): он может содержать целые числа, строки или значения с плавающей точкой, или даже другие списки.

Хранимые в списке данные определяются как разделенные запятыми значения, заключенные в квадратные скобки. Списки можно определять, используя любое имя переменной, а затем присваивая ей различные значения в квадратных скобках. Он является упорядоченным, изменяемым и допускает дублирование значений. Например:

list1 = ["Виктор", "Артем", "Роман"]

list2 = [16, 78, 32, 67]

list3 = ["яблоко", "манго", 16, "вишня", 3.4]

Далее мы рассмотрим возможные варианты кода на Python, реализующего поиск наибольшего элемента в списке, состоящем из сравниваемых элементов. В наших примерах будут использоваться следующие методы/функции:

- Встроенная функция

max() - Метод грубой силы (перебора)

- Функция

reduce() - Алгоритм Heap Queue (очередь с приоритетом)

- Функция

sort() - Функция

sorted() - Метод хвостовой рекурсии

№1 Нахождение максимального значения с помощью функции max()

Это самый простой и понятный подход к поиску наибольшего элемента. Функция Python max() возвращает самый большой элемент итерабельного объекта. Ее также можно использовать для поиска максимального значения между двумя или более параметрами.

В приведенном ниже примере список передается функции max в качестве аргумента.

list1 = [3, 2, 8, 5, 10, 6]

max_number = max(list1)

print("Наибольшее число:", max_number)

Наибольшее число: 10Если элементы списка являются строками, то сначала они упорядочиваются в алфавитном порядке, а затем возвращается наибольшая строка.

list1 = ["Виктор", "Артем", "Роман"]

max_string = max(list1, key=len)

print("Самая длинная строка:", max_string)

Самая длинная строка: Виктор№2 Поиск максимального значения перебором

Это самая простая реализация, но она немного медленнее, чем функция max(), поскольку мы используем этот алгоритм в цикле.

В примере выше для поиска максимального значения нами была определена функция large(). Она принимает список в качестве единственного аргумента. Для сохранения найденного значения мы используем переменную max_, которой изначально присваивается первый элемент списка. В цикле for каждый элемент сравнивается с этой переменной. Если он больше max_, то мы сохраняем значение этого элемента в нашей переменной. После сравнения со всеми членами списка в max_ гарантировано находится наибольший элемент.

def large(arr):

max_ = arr[0]

for ele in arr:

if ele > max_:

max_ = ele

return max_

list1 = [1,4,5,2,6]

result = large(list1)

print(result) # вернется 6

№3 Нахождение максимального значения с помощью функции reduce()

В функциональных языках reduce() является важной и очень полезной функцией. В Python 3 функция reduce() перенесена в отдельный модуль стандартной библиотеки под названием functools. Это решение было принято, чтобы поощрить разработчиков использовать циклы, так как они более читабельны. Рассмотрим приведенный ниже пример использования reduce() двумя разными способами.

В этом варианте reduce() принимает два параметра. Первый — ключевое слово max, которое означает поиск максимального числа, а второй аргумент — итерабельный объект.

from functools import reduce

list1 = [-1, 3, 7, 99, 0]

print(reduce(max, list1)) # вывод: 99

Другое решение показывает интересную конструкцию с использованием лямбда-функции. Функция reduce() принимает в качестве аргумента лямбда-функцию, а та в свою очередь получает на вход условие и список для проверки максимального значения.

from functools import reduce

list1 = [-1, 3, 7, 99, 0]

print(reduce(lambda x, y: x if x > y else y, list1)) # -> 99

№4 Поиск максимального значения с помощью приоритетной очереди

Heapq — очень полезный модуль для реализации минимальной очереди. Если быть более точным, он предоставляет реализацию алгоритма очереди с приоритетом на основе кучи, известного как heapq. Важным свойством такой кучи является то, что ее наименьший элемент всегда будет корневым элементом. В приведенном примере мы используем функцию heapq.nlargest() для нахождения максимального значения.

import heapq

list1 = [-1, 3, 7, 99, 0]

print(heapq.nlargest(1, list1)) # -> [99]

Приведенный выше пример импортирует модуль heapq и принимает на вход список. Функция принимает n=1 в качестве первого аргумента, так как нам нужно найти одно максимальное значение, а вторым аргументом является наш список.

№5 Нахождение максимального значения с помощью функции sort()

Этот метод использует функцию sort() для поиска наибольшего элемента. Он принимает на вход список значений, затем сортирует его в порядке возрастания и выводит последний элемент списка. Последним элементом в списке является list[-1].

list1 = [10, 20, 4, 45, 99]

list1.sort()

print("Наибольшее число:", list1[-1])

Наибольшее число: 99№6 Нахождение максимального значения с помощью функции sorted()

Этот метод использует функцию sorted() для поиска наибольшего элемента. В качестве входных данных он принимает список значений. Затем функция sorted() сортирует список в порядке возрастания и выводит наибольшее число.

list1=[1,4,22,41,5,2]

sorted_list = sorted(list1)

result = sorted_list[-1]

print(result) # -> 41

№7 Поиск максимального значения с помощью хвостовой рекурсии

Этот метод не очень удобен, и иногда программисты считают его бесполезным. Данное решение использует рекурсию, и поэтому его довольно сложно быстро понять. Кроме того, такая программа очень медленная и требует много памяти. Это происходит потому, что в отличие от чистых функциональных языков, Python не оптимизирован для хвостовой рекурсии, что приводит к созданию множества стековых фреймов: по одному для каждого вызова функции.

def find_max(arr, max_=None):

if max_ is None:

max_ = arr.pop()

current = arr.pop()

if current > max_:

max_ = current

if arr:

return find_max(arr, max_)

return max_

list1=[1,2,3,4,2]

result = find_max(list1)

print(result) # -> 4

Заключение

В этой статье мы научились находить максимальное значение из заданного списка с помощью нескольких встроенных функций, таких как max(), sort(), reduce(), sorted() и других алгоритмов. Мы написали свои код, чтобы попробовать метод перебора, хвостовой рекурсии и алгоритма приоритетной очереди.

Большинство моих однокурсников только и мечтали о том, как они наконец закончат универ и смогут заниматься чем-то по-настоящему крутым. Вместо скучных лекций и семинаров реальные проекты, которые действительно меняют мир вокруг.

Мне же во время учебы совсем не хватало времени на то, чтобы думать о том, что будет после диплома. Сейчас, в середине лета, наконец появилось время подумать о своем будущем.

Я решил подойти к делу обстоятельно, поэтому постарался структурировать все варианты (спойлер, их два основных), оценить все «за» и «против» и уже на основе этого мини исследования принимать решение. Надеюсь, кому-нибудь это тоже будет полезно и поможет увидеть новые возможности.

Вводные и первые выводы

Дано:

- выпускник технического вуза,

- хорошо разбираюсь в математике и знаю Python,

- рассматриваю переезд,

- хочу зарабатывать.

Основных гипотез у меня было две: работа или продолжение учебы в каком-либо виде с подработками.

Можно было еще рассмотреть варианты номер три и четыре — не делать ничего целый год или отправиться волонтером в какую-нибудь отдаленную часть света. Но если свериться с «Дано», становится понятно, что эти варианты не удовлетворяли условию моей задачи, поэтому не рассматривались.

Проверка гипотезы #1 — работа

С самого начала я был настроен на поиск удаленной работы, потому что этот вариант мне казался наиболее реальным. Знание Python и интерес к машинному обучению были на моей стороне, поэтому я вооружился чаем и начал изучать сайты с вакансиями.

За пару дней не осталось предложений в моём городе (Калининград), которые бы не попались мне два, а то и три раза. Я отправил 28 откликов на вакансии, показавшиеся мне интересными.

Основной критерий здесь был такой: если при прочтении текста вакансии я думал: «Классное место! Здесь мне будет интересно», то отправлял свое резюме.

- На мои запросы в течение недели пришло 12 ответов.

- 5 из них поблагодарили за интерес и обещали иметь меня ввиду.

- 7 пригласили на собеседование или предложили тестовые задания.

Мне показался этот результат вполне положительным. В итоге, у меня на руках были 3 перспективы получить работу.

Проверка гипотезы #2 — учеба и подработка

Эта гипотеза изначально не вызывала у меня уверенности.

Допустим, я смогу найти интересную магистратуру в моём городе — Калининграде. Но нужно будет еще искать работу, которую получится совместить с учебой. А значит, работать придётся больше, чем при варианте #1: учеба — работа — сон — учеба — и т.д. Я не против труда, но опасался, что просто не смогу качественно успевать на обоих фронтах.

И я до сих пор благодарю сам себя, что не остановился на гипотезе #1. В ней все хорошо, но я даже не думал, что смогу найти то, что полностью будет подходить под мой запрос.

Мой поиск привел меня на сайт МФТИ. Где я наткнулся на магистратуру «Системы машинного обучения для умного производства». Сразу скажу, что свой запрос на участие в отборе на грант я уже отправил. Но решил поделиться, потому что знаю, насколько иногда важно найти нужную информацию.

В общем, программу МФТИ запускает в этом году впервые в партнерстве с группой НЛМК. Это большая сталелитейная компания, которая сейчас активно проходит цифровизацию производства: это огромные площадки, где нужно продумывать и оцифровывать сотни процессов.

Я не просто так делаю на этом акцент. Первое, что меня заинтересовало в этой программе — работа под руководством IT-специалистов НЛМК над проектами компании. Ни через год или два, а с первого семестра учебы. Одна мысль о том, что во время магистратуры не придется довольствоваться только теорией, меня крайне впечатлила.

Следующий аргумент «за» — грант. Магистранты не платят за это обучение совсем. Как я понял, суть в том, что компания НЛМК готова выращивать свои кадры. Поэтому они берут тех, кто разбирается в программировании и математике, и обеспечивают им среду для роста. А за пару лет плотной работы с задачами НЛМК магистранты превращаются в спецов Data Science и инженеров искусственного интеллекта.

Кстати, о работе тоже переживать не придется. Студенты получают доход от 35 до 80 тыс. рублей и официальный опыт работы с первых дней учебы. В интервью с куратором программы Шамилем Ульбашевым я прочитал, что доход на последних курсах может расти до 140 тыс. рублей, это зависит от самого студента. Чем больше пользы приносишь, тем больше получаешь.

Смотрите, какой у меня итог:

- не платишь за учебу, при этом учишься в самых эффективных условиях: теорию отрабатываешь на реальных задачах,

- есть наставник и команда,

- получаешь доход 35-140 тыс. рублей, который зависит только от тебя.

Итог исследования

Надеюсь, что мой небольшой эксперимент поможет кому-нибудь понять, что возможностей на самом деле гораздо больше, чем кажется. За пару недель поисков я смог получить 3 потенциальных предложения о работе и найти магистратуру по моему технарскому профилю, в которой действительно захотелось учиться. Я даже готов двигать ради такой возможности в Москву!

Если кому-то интересно, вот сайт магистратуры, может, будем учиться вместе.

Удачи всем выпускникам в определении своего пути!

Автор: Игорь Макушев

]]>Новичкам не нужно жонглировать двоичными представлениями, чтобы научиться программировать на Python. Существует несколько инструментов для написания кода с простым и понятным интерфейсом. Они поощряют детей пробовать свои силы в программировании, тем самым удовлетворяя их потребность в изучении Python.

Вы можете обучать детей языку Python, не заставляя их выполнять утомительные задания по предварительному чтению гор специализированной литературы.

Python считается современным языком программирования и используется для разработки бесчисленных программных продуктов. С помощью него дети могут создавать свои приложения от простого вывода «Hello World!» до разработки анимации и игр. Программирование на Python развивает у ребенка интерес к изучению этой сферы.

Что такое Python?

Python — один из самых популярных языков программирования последнего времени. Как и любой другой язык программирования, Python помогает нам описывать различные компьютерные команды для получения желаемого результата. Синтаксис Python позволяет новичкам легко написать практически любой набор инструкций.

Например, если вы хотите отобразить «Hello!» на экране компьютера, необходимая для этого команда в Python будет выглядеть следующим образом:

print("Hello")

Такой простой набор команд и синтаксис облегчают детям изучение Python. Высокая читабельность — одна из тех особенностей языка, которая привела к его огромной популярности среди программистов. Кроме того, с помощью Python можно легко продемонстрировать важные концепции объектно-ориентированного программирования даже детям. Ниже перечислены другие полезные особенности Python.

- Встроенные структуры данных.

- Поощряет повторное использование кода.

- Наличие обширной стандартной библиотеки.

- Сверхбыстрый цикл редактирования-тестирования-отладки.

Python делает упор на простой подход к программированию, который можно интерпретировать и понять без изучения сложного синтаксиса. Кроме того, как было сказано выше, язык поддерживает повторное использование кода и разделение его на модули/пакеты. Все эти особенности делают его довольно эффективным языком программирования.

Почему дети должны изучать Python?

Поскольку этот язык известен своей легкостью восприятия, программирование на Python для детей может привить им страсть к написанию кода, не перегружая их.

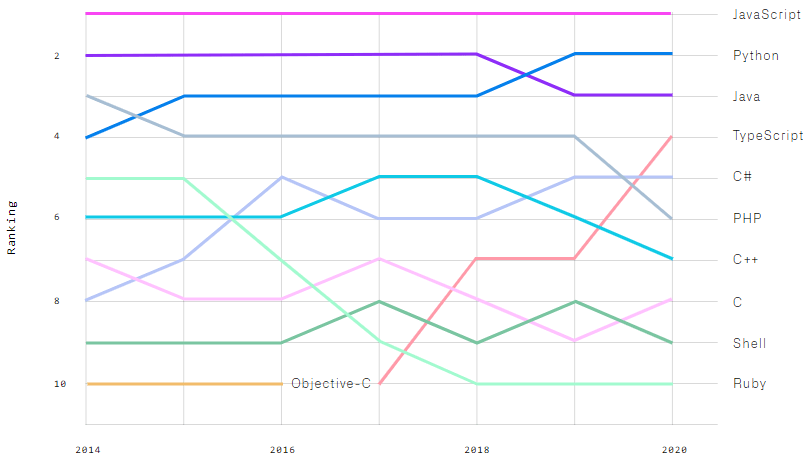

В цифровую эпоху ничто не может превзойти важность навыков программирования. Поэтому среди других языков, таких как Java, C# и т.д., он является наиболее подходящим вариантом для изучения основ написания кода ребенком.

Причины, по которым дети должны изучать Python:

- Python — один из самых гибких языков программирования. Он имеет легко читаемый набор команд и синтаксис, который гораздо менее сложен, чем в других языках программирования. Эти команды представляют собой обычные английские слова, что делает изучение Python более доступным для детей.

- Детям не нужно прочесть множество учебников, чтобы начать писать код на Python. Изучение Python для детей — вполне выполнимая задача, даже если у них нет никаких предшествующих знаний о программировании.

- Python имеет обширную стандартную библиотеку, которую можно импортировать по необходимости. Дети могут осуществить многие свои идеи при создании приложений на Python, просто добавляя нужные библиотеки. Такой подход повышает доступность Python. Дети могут написать код любой программы на Python за меньшее число шагов, чем если бы им пришлось писать на Java или C.

- Python — очень дружелюбный к детям язык программирования. Они могут экспериментировать с различными фрагментами кода и постепенно собирать из них более осмысленные программы для создания собственных видеоигр и анимации.

- Совершенно очевидно, что язык программирования Python останется с нами надолго. Поэтому для детей довольно важно изучать Python из-за широкого спектра его применения. Знание Python также даст им преимущество при получении высшего образования в области науки о данных, автоматизации, машинного обучения и веб-разработки.

- Несмотря на различные усовершенствования, базовая структура языка Python остается неизменной. Поэтому изучение программирования на Python для малышей является большим плюсом, так как их навыки точно не устареют в будущем.

- Изучение Python также повысит способность детей к критическому мышлению. Да, последовательное рассуждение — это ключ к пониманию основных концепций программирования. Поэтому написание кода на Python для различных приложений позволит детям визуализировать и в итоге осмыслить сложные абстрактные понятия программирования. Это, в свою очередь, также улучшит их способность анализировать и решать математические задачи.

Как лучше всего детям изучать Python?

Освоение программирования на Python станет более достижимым для детей, если они будут следовать хорошим ориентированным на них видеоурокам. В Интернете можно найти несколько подобных курсов, обучающих малышей Python. Также они могут изучать основы программирования на Python, обращаясь к некоторым неплохим книгам. Например, из таких учебников дети могут узнать о переменных в Python и о том, как изменение переменной влияет на вывод программы.

Самое важное, о чем нужно помнить при написании кода на Python, — это синтаксис. Существуют различные инструменты для создания кода, которые позволяют детям изучить основные понятия программирования на Python. Для обучения синтаксису они могут практиковаться в создании небольших фрагментов кода в таких инструментах.

Часто дети отказываются от изучения языков программирования из-за сложных синтаксических структур. Однако с Python и его довольно простым синтаксисом эта проблема отпадает.

Очень важно поддерживать заинтересованность детей к обучению программированию, чтобы они могли развить хорошую концептуальную базу. Для этого необходимо разбить всю информацию по конкретной теме на кусочки и поощрять маленьких студентов самостоятельно решать упражнения по Python. Это, в свою очередь, делает изучение программирования на Python для детей более доступным, не вызывая у них потери интереса.

Чем больше они будут решать упражнений, тем лучше они смогут понять основные концепции и применение различных базовых элементов программирования, таких как инициализация переменных, условные операторы, циклы, функции и т.д.

- Python — практические задачи

- Основы программирования на языке Python в примерах и задачах

- Книга «1400 задач по программированию»

Установка может оказаться очень трудоемкой для некоторых сред программирования. С Python все обстоит совершенно иначе. Для установки в Windows требуется всего три шага. Дети могут установить Python на свои компьютеры, скачав программу с официального сайта. Родителям, вероятно, стоит помочь им при выборе версии, совместимой с используемой операционной системой.

После завершения установки ребенок сразу может приступить к увлекательному процессу создания кода с нуля. Лучший способ изучения Python для детей — это написание небольших фрагментов кода и последующий их запуск в терминале или текстовом редакторе.

Некоторые из лучших книг по Python для детей

Как только у ребенка появится интерес к программированию, самое время расширить его кругозор с помощью тематических книг. Ниже перечислены некоторые из лучших учебников для детей.

Вышеупомянутые книги весьма полезны для обучения детей основам программирования.

Книга «Python для детей. Самоучитель по программированию» написана в увлекательной форме, что поможет сохранить интерес маленьких студентов к изучению этого языка программирования. Она преподносит материал в очень легкой для понимания манере, которая побуждает ребенка глубже вникнуть в концепции Python.

Книга «Python для детей и родителей. Играй и программируй» также имеет очень интересный подход. Темы, освещенные в ней, подходят для изучения языка детьми и родителями.

Что дети могут делать с Python?

Начнем с того, что они могут отображать простые сообщения типа «Hello World!» или «Good Morning!» с помощью Python на начальном уровне. Также могут выполнять и выводить простые математические вычисления с помощью функции print. Например:

>>> print("Доброе утро!")

Доброе уро!

>>> print(12 + 10 - 2)

20

С помощью функции print в Python можно выводить не только отдельные слова, но и сообщения или значения переменных. Для этого детям придется сначала освоить процесс инициализации переменных. Например:

>>> print("Клубника и\nМалина")

Клубника и

Малина

>>> x = 2

>>> print(x)

2

Помимо базовой функции print, дети могут писать программы для различных веселых интерактивных игр. Существует множество онлайн-уроков по программированию на Python для школьников, где они могут научиться писать код для видеоигр.

Кроме того, ребенок может использовать Python для создания анимации. Однако для создания более сложных проектов ему придется узнать немного больше о циклах и условных операторах.

Дети также могут попробовать свои силы в различных инструментах с открытым исходным кодом, если они хотят выйти на новый уровень программирования. От вывода имен, сообщений и арифметических вычислений до создания веселых видеоигр и других полезных программ. Python позволяет детям исследовать и творить, воплощая свои мысли и идеи в жизнь.

Ресурсы для детей

Хотя существует несколько веб-сайтов, на которых подробно рассматриваются концепции, ни один из них не предназначен для детей. Такое обилие знаний им может показаться чрезвычайно подавляющим. Именно поэтому создано несколько индивидуальную программу обучения написанию кода детей. Эти курсы разработаны таким образом, чтобы любому ребенку было очень легко войти в мир программирования. Так что, если вы хотите научить своих детей языку Python, мы рекомендуем выбирать специализированные курсы.

]]>Spark предоставляет API для Scala, Java, Python и R. Система поддерживает повторное использование кода между рабочими задачами, пакетную обработку данных, интерактивные запросы, аналитику в реальном времени, машинное обучение и вычисления на графах. Она использует кэширование в памяти и оптимизированное выполнение запросов к данным любого размера.

У нее нет одной собственной файловой системы, такой как Hadoop Distributed File System (HDFS), вместо этого Spark поддерживает множество популярных файловых систем, таких как HDFS, HBase, Cassandra, Amazon S3, Amazon Redshift, Couchbase и т. д.

Преимущества использования Apache Spark:

- Он запускает программы в памяти до 100 раз быстрее, чем Hadoop MapReduce, и в 10 раз быстрее на диске, потому что Spark выполняет обработку в основной памяти рабочих узлов и предотвращает ненужные операции ввода-вывода.

- Spark крайне удобен для пользователя, поскольку имеет API-интерфейсы, написанные на популярных языках, что упрощает задачу для разработчиков: такой подход скрывает сложность распределенной обработки за простыми высокоуровневыми операторами, что значительно снижает объем необходимого кода.

- Систему можно развернуть, используя Mesos, Hadoop через Yarn или собственный диспетчер кластеров Spark.

- Spark производит вычисления в реальном времени и обеспечивает низкую задержку благодаря их резидентному выполнению (в памяти).

Давайте приступим.

Настройка среды в Google Colab

Чтобы запустить pyspark на локальной машине, нам понадобится Java и еще некоторое программное обеспечение. Поэтому вместо сложной процедуры установки мы используем Google Colaboratory, который идеально удовлетворяет наши требования к оборудованию, и также поставляется с широким набором библиотек для анализа данных и машинного обучения. Таким образом, нам остается только установить пакеты pyspark и Py4J. Py4J позволяет программам Python, работающим в интерпретаторе Python, динамически обращаться к объектам Java из виртуальной машины Java.

Итоговый ноутбук можно скачать в репозитории: https://gitlab.com/PythonRu/notebooks/-/blob/master/pyspark_beginner.ipynb

Команда для установки вышеуказанных пакетов:

!pip install pyspark==3.0.1 py4j==0.10.9Spark Session

SparkSession стал точкой входа в PySpark, начиная с версии 2.0: ранее для этого использовался SparkContext. SparkSession — это способ инициализации базовой функциональности PySpark для программного создания PySpark RDD, DataFrame и Dataset. Его можно использовать вместо SQLContext, HiveContext и других контекстов, определенных до 2.0.

Вы также должны знать, что SparkSession внутренне создает SparkConfig и SparkContext с конфигурацией, предоставленной с SparkSession. SparkSession можно создать с помощью SparkSession.builder, который представляет собой реализацию шаблона проектирования Builder (Строитель).

Создание SparkSession

Чтобы создать SparkSession, вам необходимо использовать метод builder().

getOrCreate()возвращает уже существующий SparkSession; если он не существует, создается новый SparkSession.master(): если вы работаете с кластером, вам нужно передать имя своего кластерного менеджера в качестве аргумента. Обычно это будет либоyarn, либоmesosв зависимости от настройки вашего кластера, а при работе в автономном режиме используетсяlocal[x]. Здесь X должно быть целым числом, большим 0. Данное значение указывает, сколько разделов будет создано при использовании RDD, DataFrame и Dataset. В идеалеXдолжно соответствовать количеству ядер ЦП.appName()используется для установки имени вашего приложения.

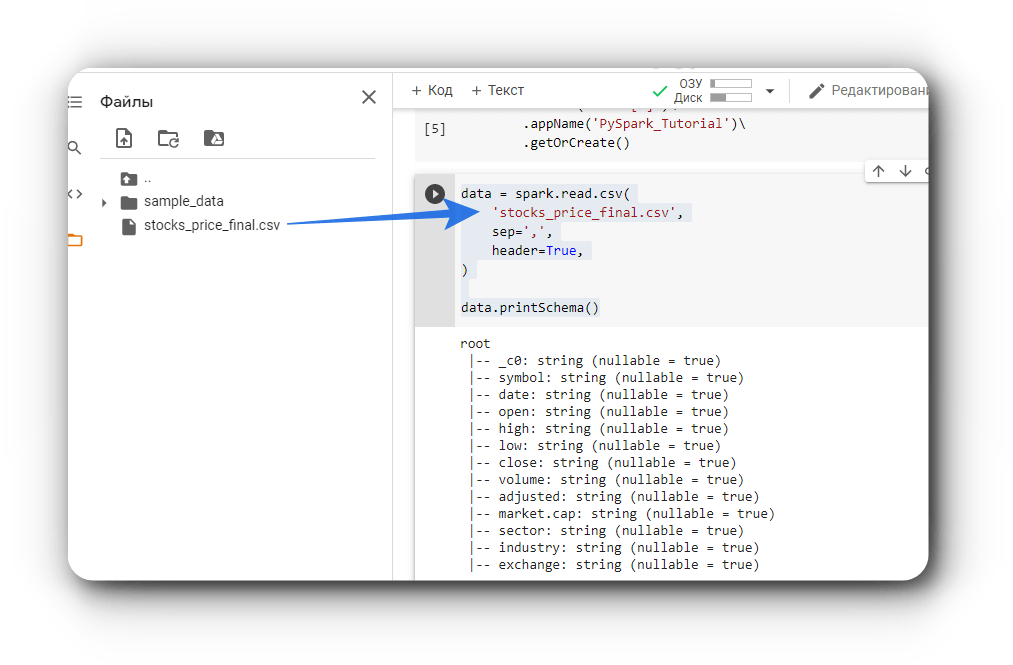

Пример создания SparkSession:

from pyspark.sql import SparkSession

spark = SparkSession.builder\

.master("local[*]")\

.appName('PySpark_Tutorial')\

.getOrCreate()

# где "*" обозначает все ядра процессора.

Чтение данных

Используя spark.read мы может считывать данные из файлов различных форматов, таких как CSV, JSON, Parquet и других. Вот несколько примеров получения данных из файлов:

# Чтение CSV файла

csv_file = 'data/stocks_price_final.csv'

df = spark.read.csv(csv_file)

# Чтение JSON файла

json_file = 'data/stocks_price_final.json'

data = spark.read.json(json_file)

# Чтение parquet файла

parquet_file = 'data/stocks_price_final.parquet'

data1 = spark.read.parquet(parquet_file)